Python/PyTorch 공부

[PyTorch] Multi_head_attention에서 target sequence length와 source sequence length 의미

AI 꿈나무

2022. 7. 27. 20:23

반응형

Multi_head_attention에서 target sequence length와 source sequence length 의미

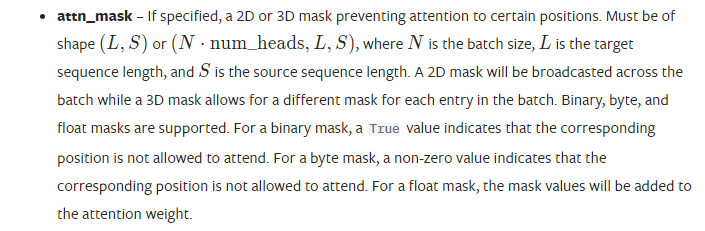

연구를 위해 pytorch의 multi head attention에 attention mask를 씌워줘야 했다.

도큐먼트를 보면 L은 target sequence length를 의미하고 S는 source sequence length를 말하는데, 이 둘은 무엇일까?

pytorch 내부 코드를 뜯어보니 target sequence length는 query의 길이를 의미한다.

soure sequence length는 key의 길이를 의미함.

구글링해도 관련 내용을 찾기 어려워서 작성해본당. 나만 모르고 다 아는 내용이라서 구글링해도 못찾았던 거일수도?

반응형