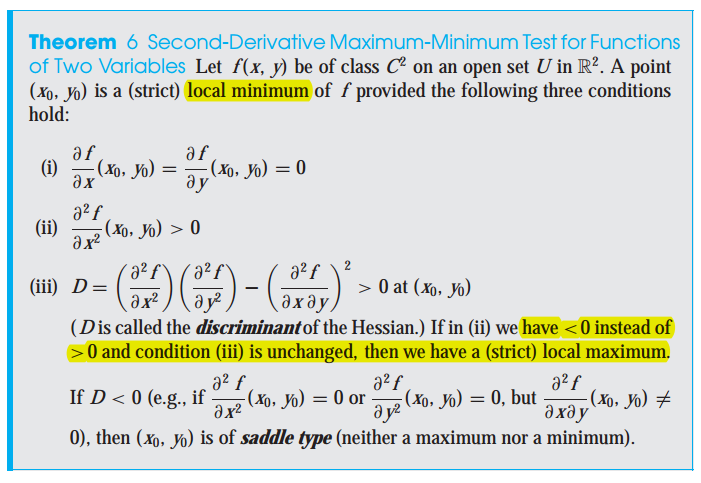

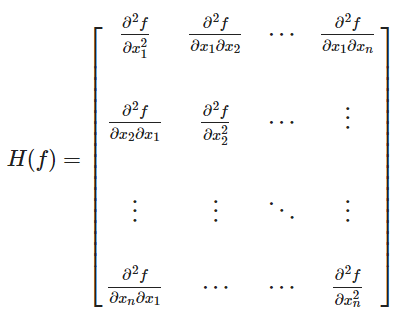

이계도함수 판정법(Second-Derivative Test for Local Extrema) 임계점(x0)에서 함수의 이차 편미분 행렬인 헤시안이 양의 정부호(positive definite)이면 x0은 극소점(relative minimum) 입니다. 비슷하게, 임계점에서 함수의 헤시안이 음의 정부호이면 x0은 극대점(relative maximum)입니다. 헤시안 행렬이 양의 정부호, 음의 정부호를 판단하는 방법은 다음과 같습니다. a가 0보다 크고, B의 determinant가 0 이상이면 헤시안 행렬은 양의 정부호 입니다. 만약, a가 0보다 작고 determinant가 0보다 크면 해시안 행렬은 음의 정부호 입니다. 2x2 보다 큰 nxn 크기의 해시안 행렬에서 양의 정부호는 다음과 같이 판별할 수..