안녕하세요, 오늘 읽은 논문은 Big Transfer(BiT): General Visual Representation Learning 입니다.

BiT는 large supervised dataset에 대하여 pre-training을 한 뒤에 target task에 모델을 fine-tunning합니다. 300M 이미지를 갖고 있는 JFT dataset으로 pre-training 하고, 20개 dataset에 대해 fine-tunning하여 강력한 성능을 나타냅니다.

즉, 엄청난 크기의 dataset으로 학습된 모델을 여러 task에 transfer 합니다.

Big Transfer

(1) Upstream Pre-Training

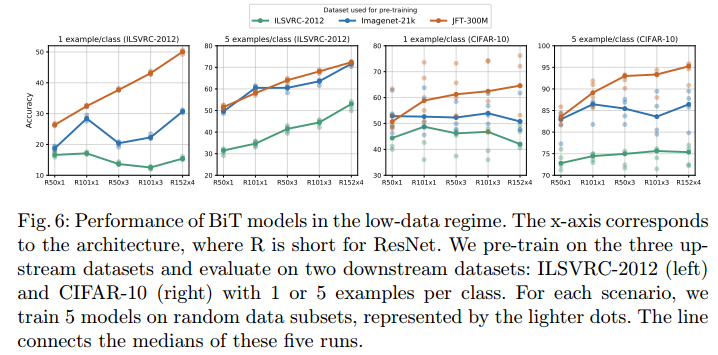

pre-training에서 dataset size, 모델 size가 미치는 역할을 조사하기 위해 3개의 dataset에 대해 3개의 BiT model을 학습합니다. 3개의 dataset은 ILSVRC-2012(BiT-S, 1.3M images), ImageNet-21k(BiT-M, 14M images), JFT(BiT-L, 300M images)

BiT는 순수한 ResNet-152x4에 Group Normalization(GN), Weight Standardization(WS) 를 사용합니다. BN대신에 GN을 사용하는 이유는 모델 크기가 너무 커서 작은 batch size를 사용해야합니다. 작은 배치 사이즈를 사용하는 경우에 BN은 안좋은 성능을 타나냅니다. 또한 BN 내부에 학습 가능한 파라미터가 존재하여 transfer시에 이를 갱신해야 합니다. 논문에서는 GN과 WS의 결합이 small-batch training에 적합하다고 합니다.

(2) Transfer to Downstream Tasks

MixUp은 transfer시에 큰 dataset과 작은 dataset에 대하여 별 효과가 없다고 합니다. mid-dataset에 대해 좋은 성능을 나타냅니다. 또한 transfer할 dataset이 크면 오랫동안 학습하고, 작으면 짧은 시간 학습을 합니다. 또한 weight decay를 사용하지 않습니다.

모든 task에 동일한 하이퍼파라미터(학습률 등등)을 사용합니다. 대신에 schedule, resolution, usage of MixUp만 dataset 특성에 따라 변경합니다.

Experiments

BiT-L 성능

BiT 종류에 따른 성능

object detection

Analysis

model size에 따른 성능 변화

few-show 성능

BN, GN, WS 실험

참고 자료