반응형

트랜스포머 헷갈리는 부분 정리

단어 토큰은 id 형태로 정수로 표현된다.

one hot 으로 표현된 단어 토큰들을 concat하여 행렬을 만들어준다.

행렬을 nn.Embedding에 전달하여 정수를 벡터로 표현한다.(학습을 통해 단어의 분산 표현이 가능해짐. 분산 표현이 가능해지면 다른 단어들과 유사도를 측정 가능)

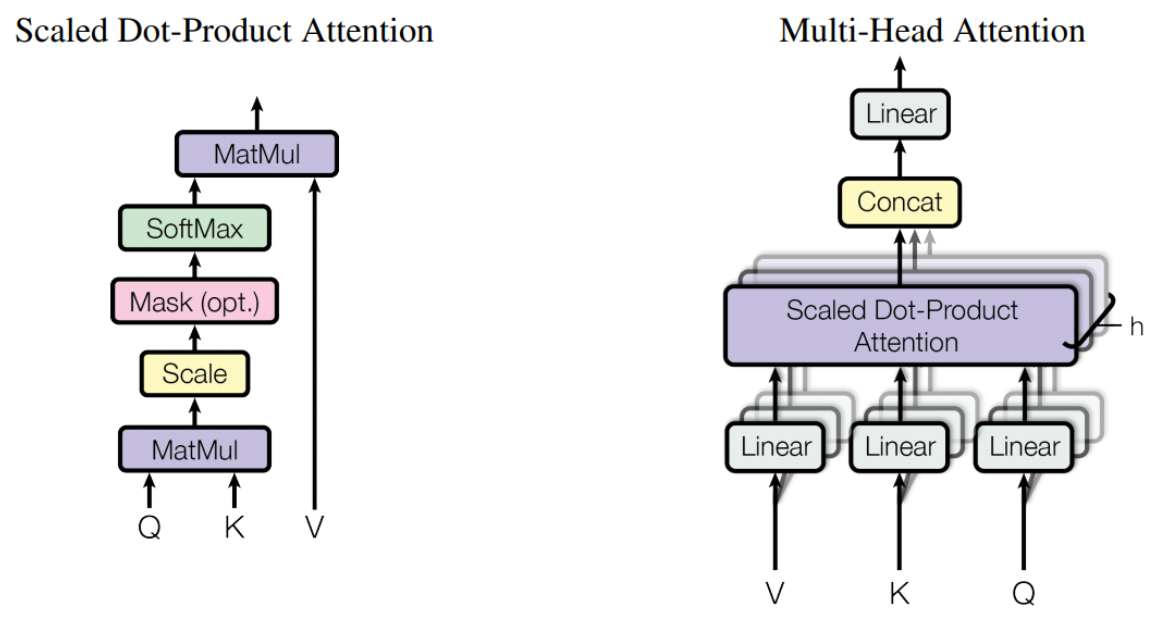

이제 단어 임베딩들을 nn.Linear에 전달하여 Key, Query, Value로 만들어줍니다.

단어 임베딩을 바로 사용하지 않고 별도의 K, Q, V로 만들어서 self-attention에 전달하는 이유는 K,Q,V의 의미가 다 다르기 떄문.

Q : 현재 기준으로 삼는 단어의 정보

K : Q와 비교할 단어의 정보

V : 실제로 각 K 단어에서 가져올 정보

Q, K, V 모두 다르게 학습됌

멀티 어텐션 헤드 개수만큼 Q,K,V를 생성

반응형

'수학 > 딥러닝 이론' 카테고리의 다른 글

| 분야별 Vision Transformer 논문 정리 (2) | 2021.08.05 |

|---|---|

| 왜 Vision Transformer가 좋은 성능을 보일까요? (0) | 2021.08.05 |

| [딥러닝] Computer Vision과 NLP에서의 attention 함께 살펴보기 (0) | 2021.06.24 |

| [딥러닝] Batch Norm 관점에서 살펴보는 batch size 가이드 라인 (0) | 2021.05.28 |

| [딥러닝] 세 가지 유명 신경망 - VGG, GoogLeNet, ResNet (0) | 2020.10.09 |