Delving Deep into the Generalization of Vision Transformers under Distribution Shifts

Chongzhi Zhang, Mingyuan Zhang, Shuanghang Zhang, arXiv 2021

PDF, Vision Transformer By SeonghoonYu July 15th, 2021

Summary

현실 세계 데이터는 ImageNet과 같이 잘 정제된 데이터가 아닌 Out-of-distribution data인 경우가 많습니다. 논문 저자는 ViT가 OOD에서의 generalization 능력을 CNN 모델과 비교하여 연구합니다.

결론먼저 말하면 (1) ViT가 CNN보다 OOD data에 generalization 능력이 뛰어납니다. (2) OOD data에서 성능을 끌어올리는 방법을 제안하여 OOD data에서 4% 성능 개선을 합니다. (3) ViT는 CNN보다 smooth learning strategy가 필요합니다.

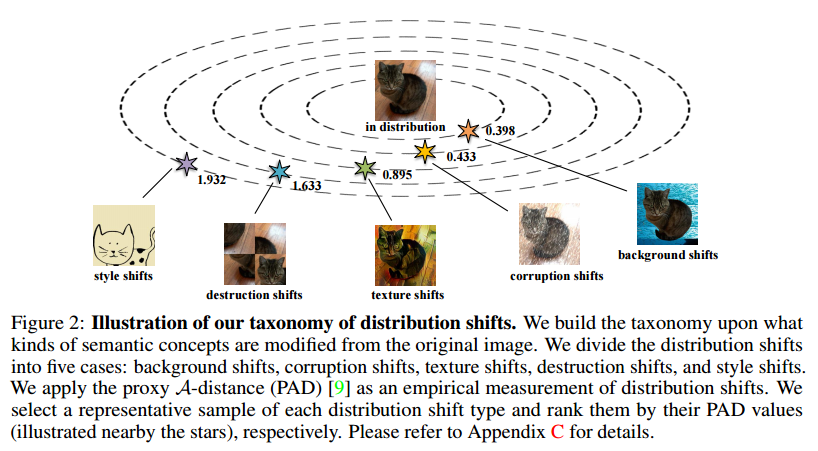

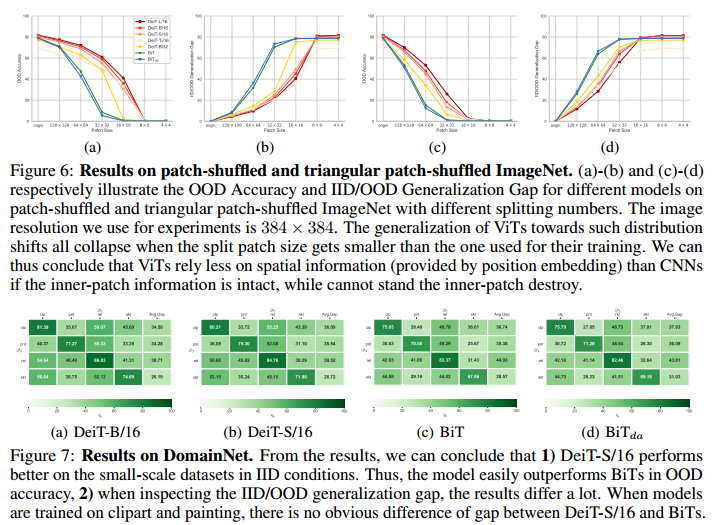

5가지 ood data set으로 실험을 합니다. base model로 Deit과 BiT를 사용하는데, 5가지 ood dataset에서 Deit의 성능이 BiT보다 뛰어납니다.

OOD data set에서 성능을 향상시키는 3가지 방법을 제안합니다. (1) domain adaptation 학습, (2) information theory 학습, (3) SSL 학습을 제안하는데, dataset에 따라 높은 성능을 기록하는 방법이 다릅니다.

Experiment

What I like about the paper

- ViT의 generalization 성능에 대한 많은 실험

my github

Seonghoon-Yu/Paper_Review_and_Implementation_in_PyTorch

공부 목적으로 논문을 리뷰하고 해당 논문 파이토치 재구현을 합니다. Contribute to Seonghoon-Yu/Paper_Review_and_Implementation_in_PyTorch development by creating an account on GitHub.

github.com