Rethinking Self-supervised Correspondence Learning: A Video Frame-level Similrity Perspective

PDF, Video SSL, Jiarui Xu, Xiaolong Wang, arXiv 2021

Summary

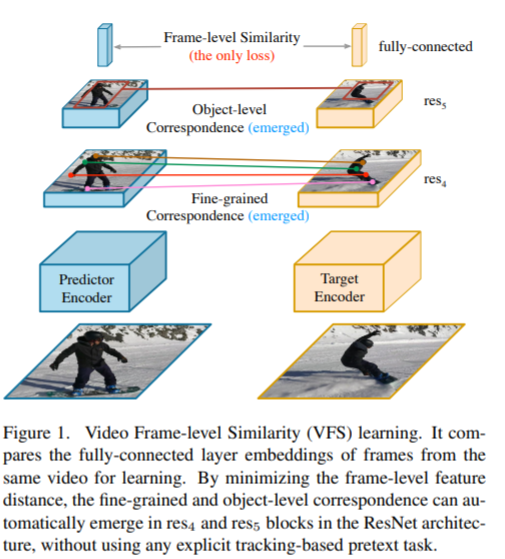

SSL 방법으로 video correspondence를 학습하는 simple framework를 제안합니다. video 내에 존재하는 temporal contencency를 supervisory signal로 사용하여 correspondence matching을 가능하게 하는 representation을 학습합니다.

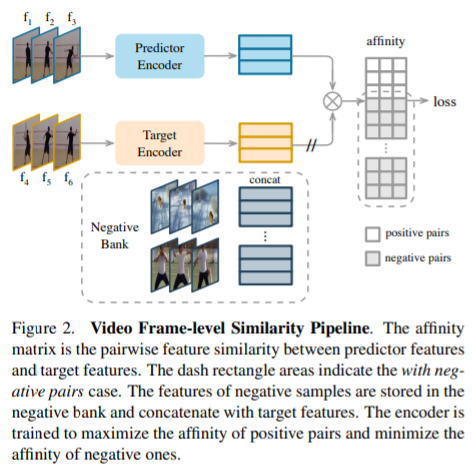

동일 비디오에서 서로 다른 프레임을 spatial augmentation을 적용한 후 predictor encoder, target encoder로 전달합니다.

서로 다른 프레임을 전달하는 이유는 different view를 제공하므로 augmentation 효과가 있습니다. color augmentation은 fine-grained task에서 성능에 악영향을 주고, object-level 에서는 성능을 향상시킵니다. fine-gradined task는 segmentation, object level은 tracking을 의미합니다. 두 task에 따라 res4와 res5에서 특징을 추출합니다.

두 encoder는 momentom parameter와 stop graient를 사용합니다. siam network의 degenerated solution을 예방하기 위함입니다.

두 인코더의 출력값의 거리를 감소하는 방향으로 학습을 진행합니다. 해당 논문에서 negative sample을 사용하지 않는데, 실험 결과 성능에 악역향을 주어 negative 없이 학습을 합니다.

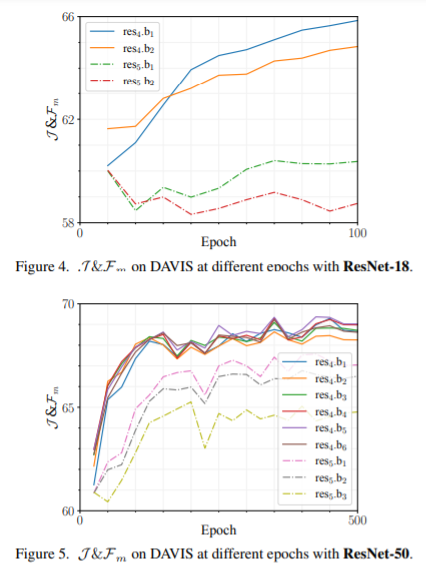

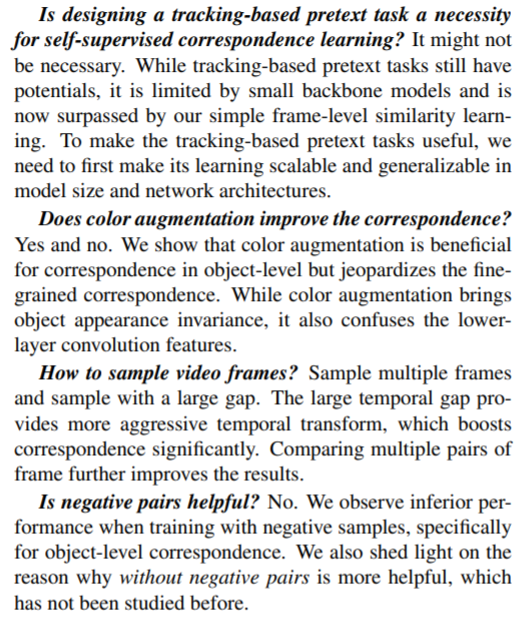

tracking based correspondence learning은 resnet-50에서 성능이 악화되지만 해당 논문은 deep model을 사용하면 성능이 향상됩니다.

Experiment

비디오 내 different frame은 augmentation 효과가 있습니다.

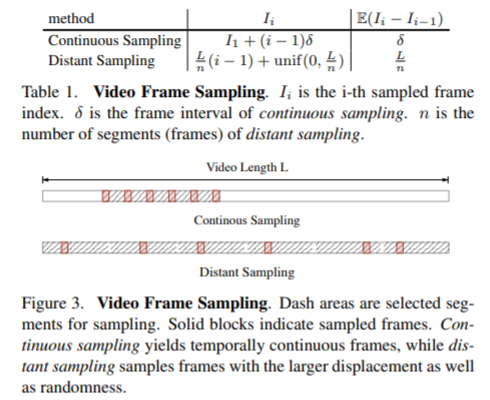

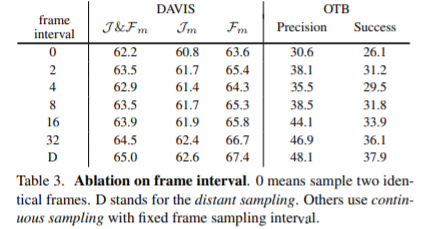

video 전체 구간에서 n개로 분할하여 분할 영역 내에서 frame을 무작위 sample하는게 효과가 좋다.

fine-grained task는 res4, object level task는 res5 추출한 특징을 사용하면 좋다

my github

Seonghoon-Yu/Paper_Review_and_Implementation_in_PyTorch

공부 목적으로 논문을 리뷰하고 해당 논문 파이토치 재구현을 합니다. Contribute to Seonghoon-Yu/Paper_Review_and_Implementation_in_PyTorch development by creating an account on GitHub.

github.com