Seesaw Loss for Long-Tailed Instance Segmentation

PDF, long-tail, Wang et al, arXiv 2020

Summary

Instance segmentation에서 long tail distribution을 다루는 논문이다.

아이디어가 재미있다.

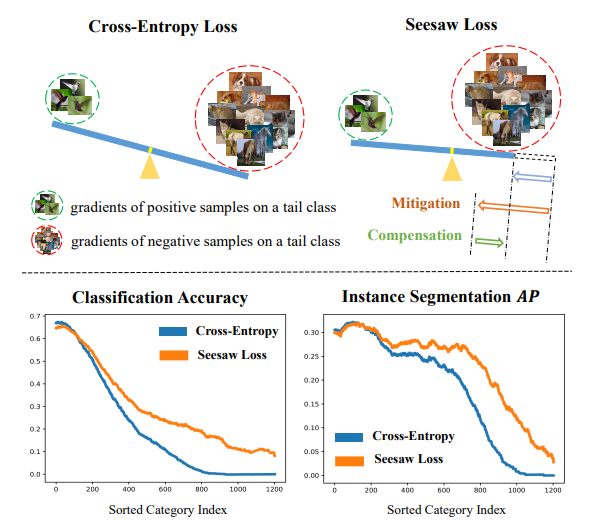

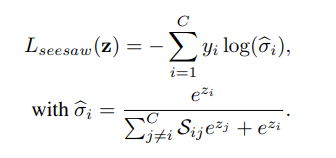

기존의 Cross-entropy loss에 두 가지 factor르 추가한다.

mitigation factor

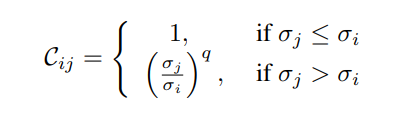

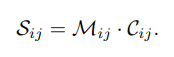

mitigation factor는 샘플 수가 많은 head 클래스가 샘플 수가 적은 tail 클래스를 억제하는 것을 완화해준다. 이게 뭔말이냐면 head class의 샘플이 입력될때마다 이에 해당하는 loss는 tail 클래스를 억제시킨다. tail 클래스에 대한 soft max 출력값이 낮아져야 head class를 잘 예측할테니까. 하지만 이렇게 head class에의해 억제된 tail class는 tail class sample을 입력 받아도 다른 class로 예측하게 된다. 이를 완하하는 factor이다. 클래스 내의 샘플을 비율로 weight를 가한다.

compensation factor

mitigation factor에 의해 tail class의 확률이 억제되는 것을 완화했다. 이로 인해 head class가 입력되었을 때, tail class로 예측할 확률이 높아졌다고 볼 수 있따. 이를 conpensation하기 위한 compensation factor가 존재한다.

head class의 sample이 입력되었을때 tail class로 예측하면 가중치를 가한다. 즉, false positive의 경우에는 가중치를 가하는 것이다. mitigation의 경우에는 항상 1보다 작거나 같았지만, compensation은 항상 1보다 크거나 같다.

이렇게 두 factor를 사용하여 seesaw loss를 구성한다.

Normalized Linear Activation

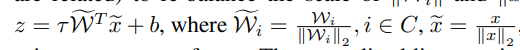

추가적으로 normalized linear activation을 제안한다. object detector의 classfier가 logit을 예측할때 z = W^T x + b를 보통 사용한다. long tail에서 이 Wi가 i class에 해당하는 클래스의 샘플 수에 높은 상관관계가 있다는 거다. i번쨰 카테고리의 샘플이 많으면 Wi가 매우 커질것이다. 이 현상은 x에서도 관측된다. 그러므로 둘에 normalize를 적용한다.

my github

Seonghoon-Yu/Paper_Review_and_Implementation_in_PyTorch

공부 목적으로 논문을 리뷰하고 해당 논문 파이토치 재구현을 합니다. Contribute to Seonghoon-Yu/Paper_Review_and_Implementation_in_PyTorch development by creating an account on GitHub.

github.com

'논문 읽기 > long tail' 카테고리의 다른 글

| [논문 읽기] Class-Balanced Loss(2019), Class-Balanced Loss Based on Effective Number of Samples (1) | 2021.06.10 |

|---|