LiT: Zero-Shot Transfer with Locked-image Text Tuning

PDF, Zero-Shot Transfer, Zhai et al, arXiv 2021

Summary

Transfer Learning과 Zero-Shot Transfer 의 차이점 먼저 설명하고 논문을 소개하겠다.

Transfer Learning은 big dataset로 pre trained된 big model을 down stream으로 fine-tuning을 하는 것이다. 즉, 두 가지 철차로 이루어진다. (1) pre-training, (2) fine-tuning. 이 과정을 통하여 데이터가 적은 task에서도 좋은 성능을 가진 모델을 사용할 수 있다.

Zero-Shot Transfer은 fine-tuning 단계를 제거한다. zero-shot model은 unseen class에 해당하는 image를 예측할 수 있다. 따라서 fine-tuning 없이도 새로운 task에 적용할 수 있다. zero-shot learning으로 학습된 model이 필요한데, 이는 일반적인 supervision model과는 학습방법이 다르다. class를 text를 사용하고, image encoder가 추출한 feature와 text embedding 사이의 alignment를 잘 맞춰주어야 한다.

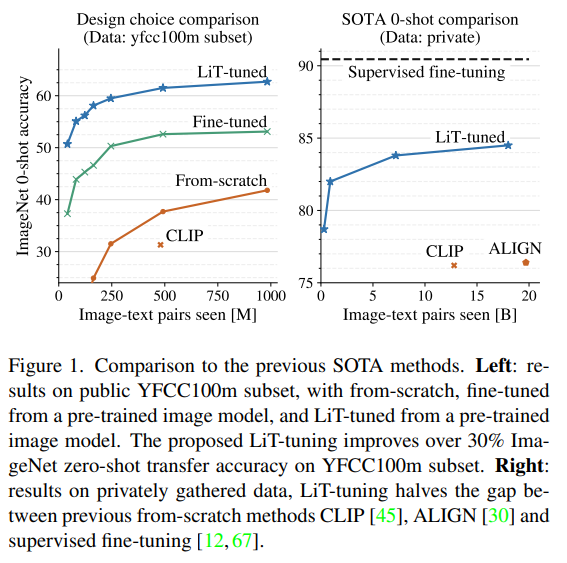

해당 논문은 zero-shot transfer이 잘 이루어지는 setting에 대한 연구이다.

세 가지 setting을 실험한다. L은 super vision으로 pre-trained 된 모델을 freeze 한것, U는 pre-trained 모델로 초기화해서 fine tune, u는 initialize 없이 scratch 부터 학습된 것을 의미한다.

supervision pre-trainined 모델을 사용하기 위해서는 출력값 차원을 변경해주는 MLP head가 필요하다. word embedding 차원과 image encoder 출력값 차원을 맞추어야 하기 때문이다.

아무튼 zero-shot learning을 위해서 image와 text encoder 가 필요한데, 이 둘의 출력값을 alignment해줘야 한다.

해당 논문에서는 image encoder은 pre-trained model 불러와서 freeze 시키고, text encoder은 바닥부터 학습시키는게 좋다고 한다.

image encoder가 좋은 representation을 추출하면 이 representation을 text encoder가 읽고, 그에 해당하는 word embedding을 학습할 것이다.

my github

Seonghoon-Yu/Paper_Review_and_Implementation_in_PyTorch

공부 목적으로 논문을 리뷰하고 해당 논문 파이토치 재구현을 합니다. Contribute to Seonghoon-Yu/Paper_Review_and_Implementation_in_PyTorch development by creating an account on GitHub.

github.com