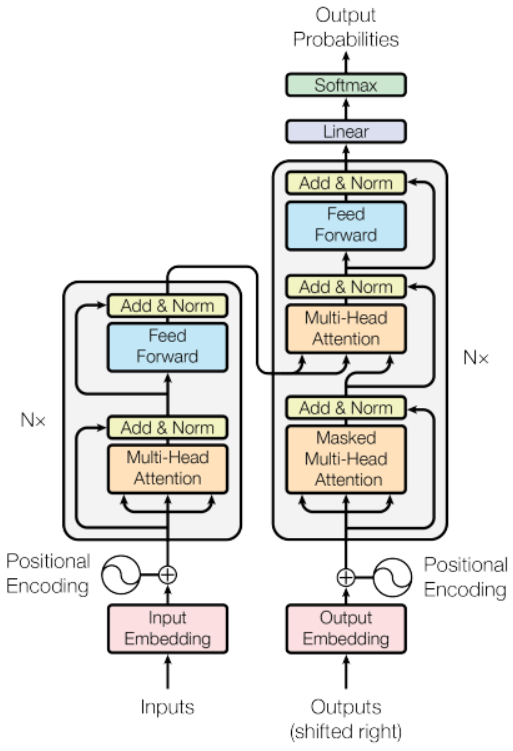

안녕하세요, 오늘 읽은 논문은 transformer을 제안하는 Attention is All You Need 입니다. 논문에서는 self-attention 으로 구성된 encoder와 decoder을 사용합니다. self-attention 작동 방법이 이해가 되질 않아서 2~3일 동안 공부했네요..ㅎㅎ 저는 이해가 잘 안될때는 코드와 함께 보는 편입니다. 코드를 보면서 어떤 과정으로 데이터가 처리되는지 확인하면 이해가 더 잘되는 것 같아요. 자연어처리 모델은 익숙하지가 않아서 아래 깃허브를 참고하면서 공부했어요. 구현 코드와 논문 설명이 함께 되어 있어서, 큰 도움이 되었습니다 ㅎㅎ bentrevett/pytorch-seq2seq Tutorials on implementing a few sequence-..