Learning Representations by Maximizing Mutual Information Across Views

Philip Bachman, R Devon Hjelm arXiv 2019

PDF, SSL By SeonghoonYu August 8th, 2021

Summary

(1) 하나의 이미지에 random augmentation을 적용하여 두 개의 view (x1, x2) 를 생성합니다.

(2) 각각을 encoder에 전달합니다. f(x1), f(x2)

(3) f(x1), f(x2)의 feature map의 index 사이의 상호정보량을 계산합니다. feature map은 1-to-5, 1-to-7, 5-to-5 로 설정하며 index는 uniform하게 sample 합니다.

Loss는 NCE Loss를 사용합니다.

Mixture-Based Representation을 사용하는데, 어떤 말인지 이해가 안됩니다. mixture feature을 사용하여 손실 함수를 다음과 같이 변경합니다. 왜 mixture feature를 사용하는지 잘 모르겠습니다. 구글에 검색해도 안나오네요. 18~19년도 SSL 논문은 읽기가 어렵습니다.

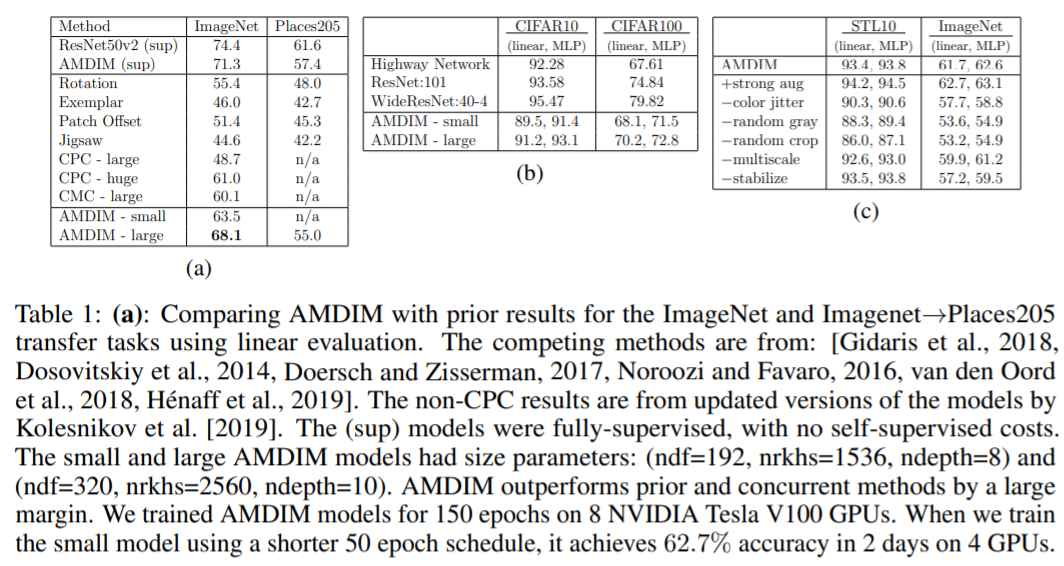

Experiment

my github about what i read

Seonghoon-Yu/Paper_Review_and_Implementation_in_PyTorch

공부 목적으로 논문을 리뷰하고 해당 논문 파이토치 재구현을 합니다. Contribute to Seonghoon-Yu/Paper_Review_and_Implementation_in_PyTorch development by creating an account on GitHub.

github.com