Supervised Contrastive Learning

Prannay Khosla, Piotr Teterwak, Chen Wang, Aaron Sarna, arXiv 2020

PDF, Supervised Learning By SeonghoonYu August 10th, 2021

Summary

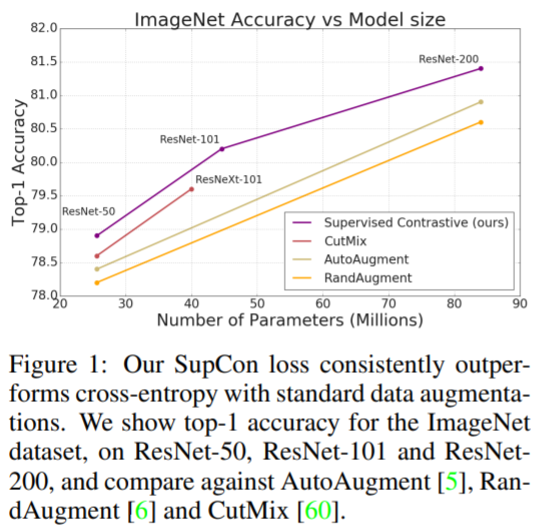

Self supervised Learning에서 주로 사용하는 Contrastive Learning 방법을 Supervised Learning에 적용한 Loss를 제안합니다. 해당 Loss는 기존에 많이 사용하는 Cross-Entropy Loss의 성능을 능가합니다.

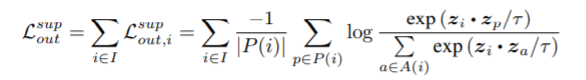

Supervised Learning에 Contrastive Learning을 적용하면 동일 Class의 image를 positive sample로 사용할 수 있습니다. 즉, 해당 논문은 많은 positive sample과 많은 negative sample을 사용하여 이점을 얻습니다.

모델은 (1) Data Augmentation module, (2) Encoder Network, (3) Projection Network, 세 요소로 구성되어 있습니다.

하나의 이미지에 augmentation을 두 번 적용하여 2개의 image copy를 생성합니다. 따라서 N개의 batch가 2N 개의 batch가 됩니다. Self supervised learning에서 사용하는 기존 Contrastive Loss 와 차이점은 동일 class에 속하는 image는 positive로 사용하여 많은 positive를 활용합니다.

Experiment

What I like about the paper

- 많은 Positive sample 또한 성능 향상에 도움이 됩니다.

my github about what i read

Seonghoon-Yu/Paper_Review_and_Implementation_in_PyTorch

공부 목적으로 논문을 리뷰하고 해당 논문 파이토치 재구현을 합니다. Contribute to Seonghoon-Yu/Paper_Review_and_Implementation_in_PyTorch development by creating an account on GitHub.

github.com