Efficient Self-supervised Vision Transformers for Representation Learning

PDF, SSL, Chunyuan Li, Jianwei Yang, Pengchuan Zhang, Mei Gao, Bin Xiao, Xiyang Dai, Lu Yuan, Jianfeng Gao, arXiv 2021

Summary

ViT에 SSL을 적용하는 논문입니다.

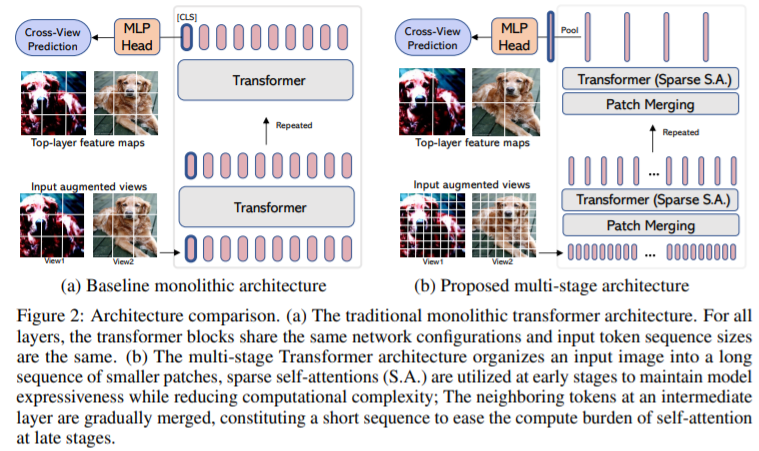

논문에서는 multi-stage architecture를 사용합니다.

multi-stage architecture를 사용하면 (1) 연산량 감소, (2) 계층 구조를 사용할 수 있습니다.

multi-stage architecture를 사용하기 위해 patch merging을 사용하는데, 이미지를 더 큰 패치로 짤라서 토큰 수를 감소시켜 transformer 연산량을 감소합니다.

일반적은 transformer 대신에 multi-stage 구조를 사용하면 transformer의 attention map 특성을 상실합니다.

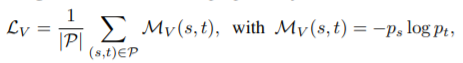

loss function은 다음과 같습니다. DINO와 같은 siam network를 사용하는데, student와 teacher 모델을 이용합니다. global view는 teacher로 전달하고 all view는 student로 전달합니다. view-level과 region-level loss를 따로 계산합니다.

Experiment

my github

Seonghoon-Yu/Paper_Review_and_Implementation_in_PyTorch

공부 목적으로 논문을 리뷰하고 해당 논문 파이토치 재구현을 합니다. Contribute to Seonghoon-Yu/Paper_Review_and_Implementation_in_PyTorch development by creating an account on GitHub.

github.com