Language-Driven Semantic Segmentation

PDF, Zero-Shot Segmentation, Anonymous, ICLR 2022 open review

Summary

CLIP을 segmentation에 적용한 페이퍼이다.

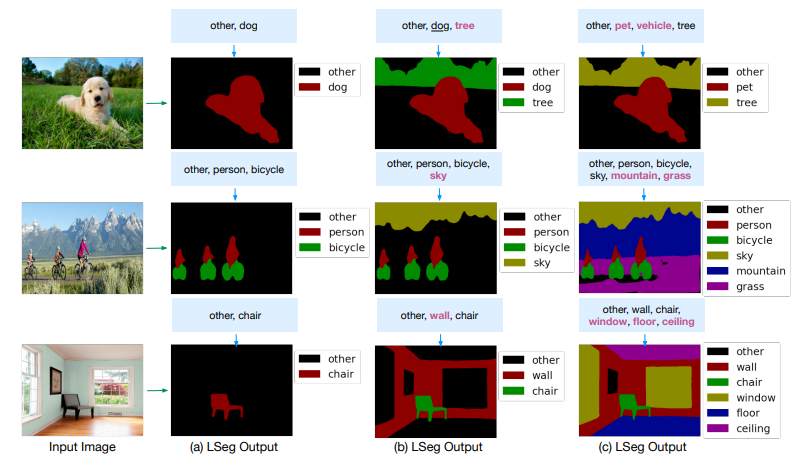

Inference시에 label를 flexible하게 넣어줄 수 있다. 즉, 이미지에서 원하는 객체만 찾을 수 있다는 말. class를 dog와 other만 넣어주면 나머지는 other로 분류한다.

Text encoder은 pre-trained CLIP을 freezing하여 사용한다. image encoder은 DPT를 사용하는데 DPT는 pretrained ViT를 encoder로 사용하고 decoder DPT를 random 초기화하여 학습시킨다.

text encoder가 제공하는 word embedding과 image encoder 출력값 사이의 내적을 계산한다. 즉, image encoder는 이미지를 입력 받아 각 pixel에 대한 C차원 벡터를 출력하는데, 이 C차원 vector는 text encoder의 word embedding과 동일해지도록 학습을 한다.

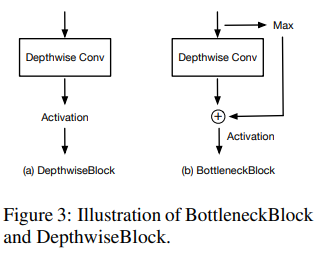

memoty constraints 때문에 image encoder은 input image보다 낮은 resolution의 feature map을 출력한다. 이를 후처리 하기 위한 Spatial regularization을 제안한다.

두 가지 variants를 제안하는데 (b)가 성능이 더 좋다. text encoder와 image encoder의 내적한 feature map에 이 모듈을 적용하는데, feature map의 채널은 n개의 label에 해당하는 내적 값이다. 따라서 channel 사이의 상호작용이 없이, 독립적으로 conv를 수행한다. (b)를 여러번 적용한 후에 bilinear interpolation을 적용하여 원래 이미지 resolution으로 복원한다.

my github

Seonghoon-Yu/Paper_Review_and_Implementation_in_PyTorch

공부 목적으로 논문을 리뷰하고 해당 논문 파이토치 재구현을 합니다. Contribute to Seonghoon-Yu/Paper_Review_and_Implementation_in_PyTorch development by creating an account on GitHub.

github.com