https://arxiv.org/abs/2107.13807

FREE: Feature Refinement for Generalized Zero-Shot Learning

Generalized zero-shot learning (GZSL) has achieved significant progress, with many efforts dedicated to overcoming the problems of visual-semantic domain gap and seen-unseen bias. However, most existing methods directly use feature extraction models traine

arxiv.org

FREE, Feature Refinement for Generalized Zero-Shot Learning

기존 Zero Shot Learning 모델은 domain gap과 seen bias problem에만 집중해왔다. 이 논문은 새로운 문제점을 제기하는데 cross-dataset bias 이다. imageNet으로 학습된 백본을 generalized zero shot 데이터셋에 적용하면 안좋은 퀄리티의 visual feature이 생성된다. 즉, 두 데이터셋 사이에 distribution mismatch 가 발생한다는 말. 이를 완화하기 위해서는 fine-tuning 과정이 필요한데, fine-tuning은 overfitting 문제와 data-insufficient 문제가 발생한다. 해당 논문은 cross-dataset bias 문제점에 집중한 논문.

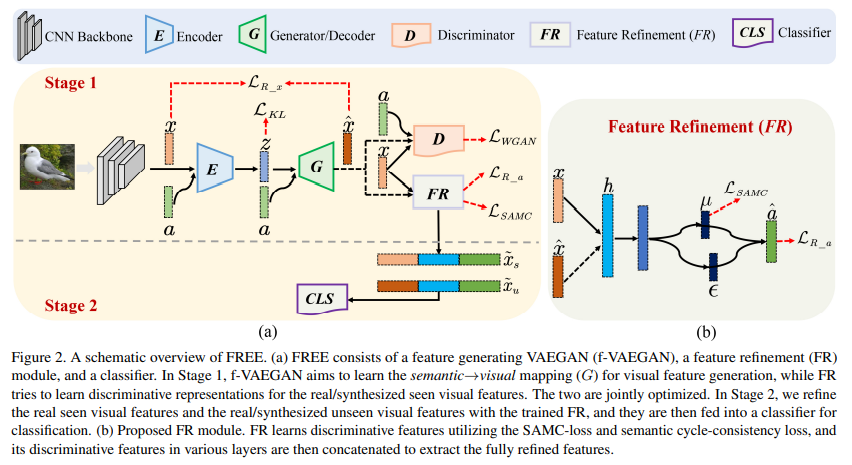

모델 base는 f-VAEGAN이다. 여기에 cross-dataset bias를 해결하기 위해 FR module과 SAMC-loss, semantic cycle-consistency loss를 제안함.

SAMC-loss(Self-Adaptive Margin Center Loss)는 RF이 더 discriminative한 class-relevant representation을 추출하기 위함이다.

샘플이 visual space 상에서 semantic attribute에 해당하는 class에 가까워지도록하고, random으로 선택한 c와 멀어지도록 한다. 재밌는 점은 refine module에서 중간 feature를 추출해서 loss를 가한다.

그리고 semantic cycle-consistency loss는 visual feature를 입력 받아 attribute를 복원하는 작업을 한다. 이를 통하여 semantically-relavant represenatation을 학습할 수 있다.

위에서 설명한 두 loss를 통해 refine module이 학습되면 x,h,a를 concat하여 refine된 visual feature를 생성해 classifier에 전달한다.

즉, 핵심은 refine module 이라는 건데, 이 refine module이 cross-dataset bias 문제를 완화한다는 것이다. 그냥 backbone이 추출한 visual feature를 사용하지 않고 정제 과정을 거친다. 정제 과정에는 SAMC loss와 semantic cycle-consistency loss가 추가되는데, SAMC loss는 intra, inter class가 discriminative하게하고, semantic cycle-consistency loss는 attribute를 복원하는 과정을 통하여 semantic한 정보를 학습시키도록 한다.