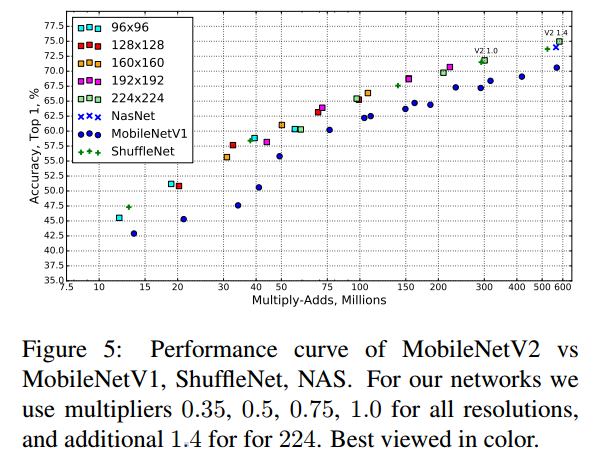

안녕하세요! 이번에 읽어볼 논문은 ShuffleNet: An Extremely Efficient Convolutional Neural Network for Mobile Devices 입니다. ShuffleNet은 경량화에 집중한 모델입니다. 또 다른 경량화 모델인 MobileNetV1을 능가합니다. 그리고 AlexNet과 비교하여 동일한 정확도로 13배나 더 빠릅니다. MobileNetV1와 Xception에서 연산량을 줄이기 위해 사용하는 Depthwise separable convolution을 기억하시나요? Xception은 Depthwise separable convolution으로 연산량을 감소한 만큼 깊이를 증가시켰었죠. 반대로 MobileNet은 Depthwise separable convo..