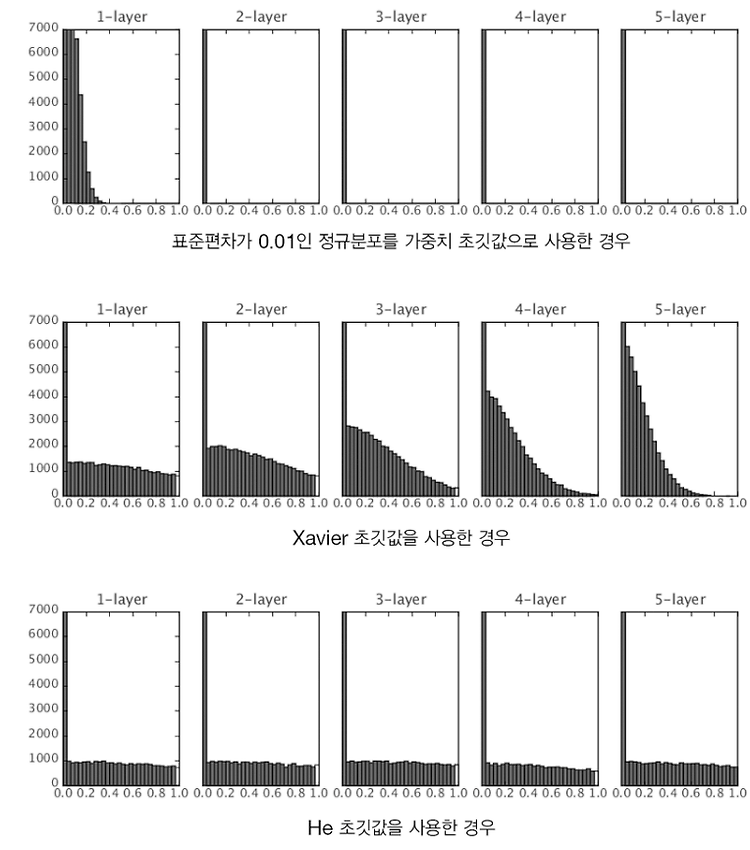

사이토고키의 을 공부하고 정리해보았습니다. [딥러닝] 1. 가중치의 초깃값 - 초깃값을 0으로 하면? 사이토고키의 을 공부하고 정리해보았습니다. 가중치의 초깃값 신경망 학습에서 특히 중요한 것이 가중치의 초깃값입니다. 가중치의 초깃값을 무엇으로 설정�� deep-learning-study.tistory.com 이전 포스팅에서 가중치의 초깃값을 적절히 설정하면 각 층의 활성화값 분포가 적당히 퍼지면서 학습이 원활하게 수행됨을 배웠습니다. 배치 정규화 - Batch Normalization 그렇다면 각 층이 활성화를 적당히 퍼뜨리도록 '강제'해보자는 아이디어에서 출발할 것이 배치 정규화 방법입니다. 배치 정규화는 2015년에 제안된 방법입니다. 배치 정규화는 세상에 나온 지 얼마 안 된 기법임에도 많은 연구..