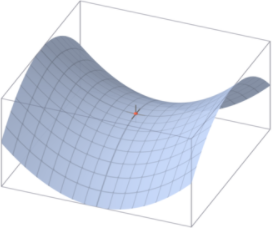

안녕하세요! 이번에 리뷰할 논문은 'An overviw of gradient descent optimization' 입니다. 이 논문은 독자에게 optimization algorithm에 대한 직관력을 제공할 목적으로 작성했다고 합니다. optimization에 대해 이해도가 높아지면 설계한 모델에 적합한 algorithm을 선택할 수 있다고 합니다. 이해도를 높이기 위해, gradient descent의 3가지 변종을 살펴보고 해결해야 할 문제점을 제시하고 이 문제점을 해결하기 위해 제시된 8가지 algorithms(Adam, RMSprop, Adagad 등등)를 소개합니다. 경사 하강법(Gradient descent) 논문의 Introduction에 경사 하강법(gradient descent)에 대해..