반응형

사이토고키의 <밑바닥부터 시작하는 딥러닝>을 공부하고 정리해보았습니다.

오버피팅(과적합)

기계학습에서는 오버피팅이 문제가 되는 일이 많습니다.

오버피팅이란 신경망이 훈련 데이터에만 지나치게 적응되어 그 외의 데이터에는 제대로 대응하지 못하는 상태를 말합니다.

기계학습은 범용 성능을 지향합니다.

훈련 데이터에는 포함되지 않는, 아직 보지 못한 데이터가 주어져도 바르게 식별해내는 모델이 바람직합니다.

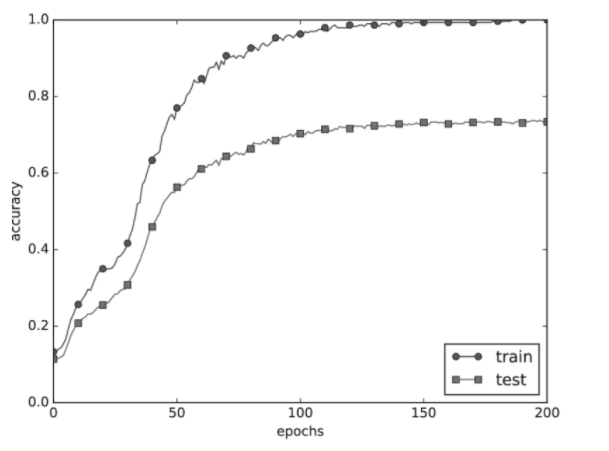

오버피팅된 모델의 훈련 데이터와 시험 데이터의 에폭별 정확도 추이를 확인해 보겠습니다.

훈련 데이터르 사용하여 측정한 정확도는 100 에폭을 지나는 무렵부터 거의 100%입니다.

그러나 시험 데이터에 대해서는 큰 차이를 보입니다.

이처럼 정확도가 크게 벌어지는 것은 훈련 데이터에만 적응해버린 결과입니다.

훈련 때 사용하지 않는 범용 데이터(시험 데이터)에는 제대로 대응하지 못하는 것을 이 그래프에서 확인할 수 있습니다.

다음 포스팅에서는 오버피팅 억제법에 대해 알아보겠습니다.

반응형

'수학 > 딥러닝 이론' 카테고리의 다른 글

| [딥러닝] 3. 오버피팅 억제법 - 드롭아웃 (0) | 2020.10.03 |

|---|---|

| [딥러닝] 2. 오버피팅 억제법 - 가중치 감소 (0) | 2020.10.03 |

| [딥러닝] 배치 정규화의 알고리즘과 효과 (0) | 2020.10.03 |

| [딥러닝] 3. 가중치의 초깃값 - ReLU를 사용할 때의 가중치 초깃값 - He 초깃값 (0) | 2020.10.03 |

| [딥러닝] 2. 가중치의 초깃값 - 가중치의 초깃값에 따라 은닉층의 활성화값 분포 변화, Xavier 초깃값 (2) | 2020.10.02 |