Scaling Vision Transformers

PDF, Vision Transformer, Xiaohua Zhai, Alexander Kolesnikov, Neil Houlsby, Lucas Beyer arXiv 2021

Summary

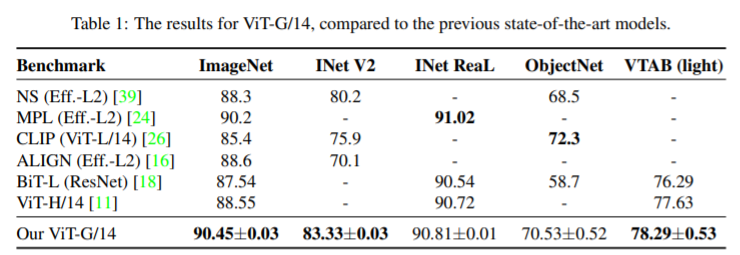

2 bilion 파라미터를 가진 ViT-G 모델을 학습하여 90.45% SOTA 성능을 달성합니다.

논문에서 여러가지 실험 결과를 보여줍니다. 인상 깊었던 몇 가지를 살펴보겠습니다.

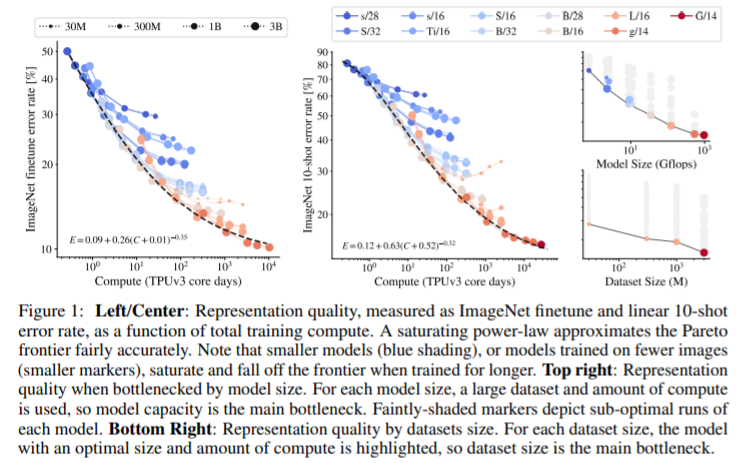

모델 size와 data size 사이의 관계를 실험합니다. 이는 직관과 동일한 실험 결과를 도출합니다. model size와 data size이 클수록 좋은 성능을 달성합니다.

downstream task에 trasnfer learning을 진행할 때, ViT에서 예측을 수행하는 head에 높은 weight decay를 적용하면 더 좋은 성능을 갖습니다. 반면에 pre-train시에는 낮은 weight decay가 적합합니다.

class token이 필수 요소가 아니라는 것을 보여줍니다. class token에 head를 적용하여 예측하는 대신 global average pooling 혹은 multi head attention pooling을 사용해도 준수한 성능을 보여줍니다. class token 또한 연산량에 포함되므로 이를 없앨 수 있으면 ViT의 연산량을 감소할 수 있습니다.

my github

Seonghoon-Yu/Paper_Review_and_Implementation_in_PyTorch

공부 목적으로 논문을 리뷰하고 해당 논문 파이토치 재구현을 합니다. Contribute to Seonghoon-Yu/Paper_Review_and_Implementation_in_PyTorch development by creating an account on GitHub.

github.com