Early Convolutions Help Transformers See Better

Tate Xiao, Mannat Singh, Eric Mintum, Trevor Darrell, Piotr Dollar, Ross Girschick, arXiv 2021

PDF, Vision Transformer By SeonghoonYu August 9th, 2021

Summary

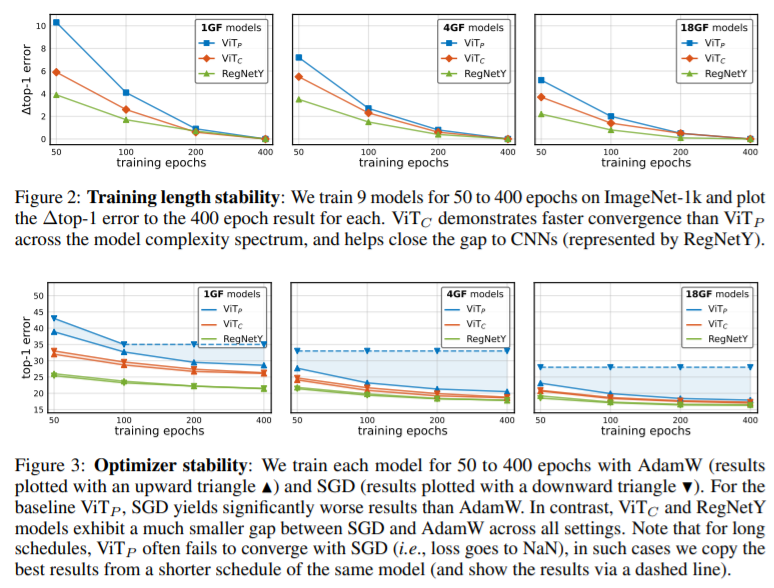

ViT는 Optimization에 민감합니다. 느린 수렴속도, Optimizer SGD를 사용하면 수렴이 안되고 lr 또는 weight decay 계수에도 민감합니다. 또한 ImageNet 에서 CNN의 성능을 뛰어넘지 못합니다.

저자는 ViT가 Optimization에 민감한 이유가 ViT의 초기 image를 patch 단위로 자를 때 사용하는 s stride와 s x s kernel size를 지닌 Conv 연산 때문이라고 말합니다.

따라서 ViT의 초기 Conv 연산을 여러 3x3 conv로 대체하여 실험합니다.

ViTc-1GF : 4개의 3x3 Conv, 채널 수 [24,48,96,192], stride 2 or 1 을 사용합니다. 채널 수가 2배가 되는 구간에 stride=2인 conv를 사용합니다. 이와 같은 방식으로 ViTc-4GF, ViTc-18GF, ViTc-36GF를 구성합니다. 해당 포스팅은 요약이 목적이므로 자세한 구현 사항은 논문을 참고하시길 추천합니다.

해당 논문에서 ViTp(기존 ViT) 와 ViTc(수정된 ViT) 사이의 4가지 요소를 Test 합니다.

Experiment

What I like about the paper

- 다양한 실험

my github about what i read

Seonghoon-Yu/Paper_Review_and_Implementation_in_PyTorch

공부 목적으로 논문을 리뷰하고 해당 논문 파이토치 재구현을 합니다. Contribute to Seonghoon-Yu/Paper_Review_and_Implementation_in_PyTorch development by creating an account on GitHub.

github.com