Spatially Consistent Representation Learning

PDF, SSL, Byungseok Roh, Wuhyun Shin, Ildoo Kim, Sungwoong Kim, CVPR 2021

Summary

Localization task를 위한 SSL 방법입니다.

기존 좋은 성능을 보였던 Contrastive Learning SSL 방법은 encoder의 출력값의 low-dimension embedding을 활용하여 Loss를 설계했었습니다. low-dimension embedding 사이의 정보를 활용하므로 positive 사이의 global representation이 일치하도록 학습을 진행하기 때문에 서로 다른 정보를 내포하고 있는 local region 사이에도 consistent한 값을 도출할 수 있습니다. 이러한 성질 때문이 localization task에서는 적합하지 않았습니다.

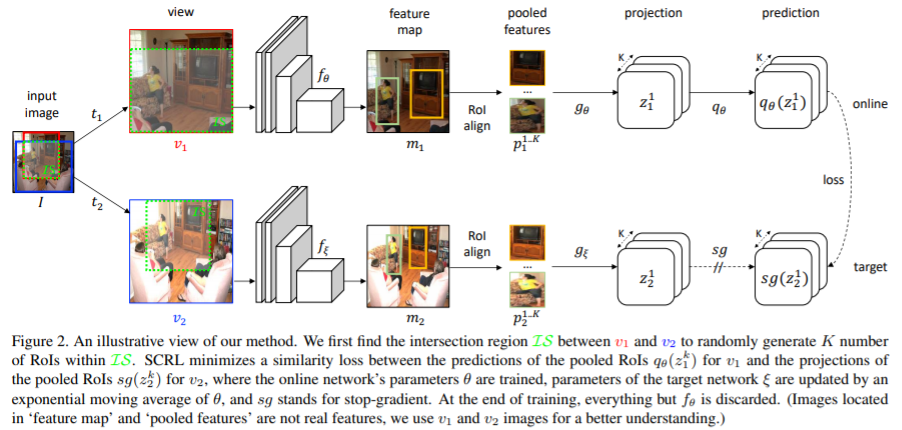

논문에서 제안하는 Spatially Consistent Representation(SCRL)은 global consistency가 아닌 spatial consistency를 학습하도록 설계합니다. 즉, global image를 보는 것이 아니라 객체 RoI 사이의 loss를 최소화하도록 설계함으로써 spatial consistency를 학습합니다.

BYOL와 비슷한 framework를 사용합니다.

단일 이미지에서 두 개의 augmentation view를 준비합니다. 두 view 사이의 overlab 영역을 IS로 지정합니다. IS 내의 랜덤 RoI를 10개 선정합니다.

선정된 RoI가 다른 RoI와의 IoU가 50% 넘으면 reject 합니다. 두 view 사이의 RoI를 일치하기 위하여 shear, shift 같은 augmentation 는 제외합니다.

2개의 different view 에서 생성된 각각의 10개 RoI를 2개의 CNN(online network, target network)에 전달하고 Mask RCNN의 RoI align을 적용하여 고정된 크기의 feature map을 생성합니다. 이 feature map에 g(FC-ReLU-FC) 를 적용하여 feature map 을 생성하고 이 피쳐맵에 q(FC-ReLU-FC)를 적용합니다.

손실함수는 BYOL과 유사합니다.

이런식으로 두 CNN의 출려값인 RoI의 encoding representation 사이의 MSE를 Loss로 설계한다면 spatial consistency를 학습할 수 있습니다.

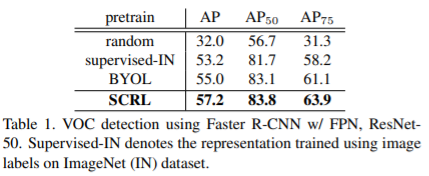

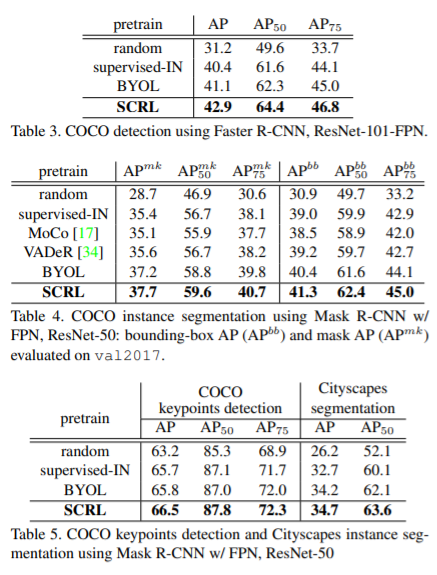

이렇게 학습한 모델은 Localization task에 뛰어난 성능을 보여줍니다.

Experiment

my github

Seonghoon-Yu/Paper_Review_and_Implementation_in_PyTorch

공부 목적으로 논문을 리뷰하고 해당 논문 파이토치 재구현을 합니다. Contribute to Seonghoon-Yu/Paper_Review_and_Implementation_in_PyTorch development by creating an account on GitHub.

github.com