Self-supervised Learning for Video Correspondence Flow

PDF, Video SSL, Zihang Lai, Weidi Xie, BMVC 2019

Summary

Tracking Emerges by Colorizing VIdeos의 문제점을 개선한 논문입니다.

Tracking Emerges by Colorizing Videos는 (1) 흑백 이미지를 입력으로 하여 모델을 학습시켰기 때문에 RGB 색상 채널 사이의 correlation을 포착하지 못합니다. 또한 (2) ground truth video frame의 pair로 학습을 하여 tracker drifting 문제가 발생합니다.

해당 논문은 위에서 언급한 문제점을 개선하기 위해 4가지 방법을 제안합니다.

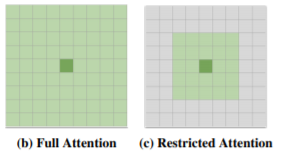

(1) Restricted Attention

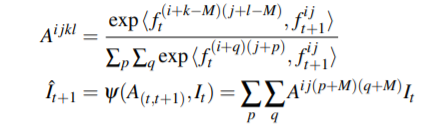

reference frame과 target frame 사이의 유사도를 계산하는 것은 큰 연산량이 요구됩니다. 따라서 유사도를 계산할 영역을 (2M+1) * (2M+1) patch 로 제한합니다.

이는 유사도 행렬 A의 계산에 필요한 연산량을 감소시키고 모델 정규화 효과가 존재합니다.

(2) Feature Embedding with Information Bottleneck

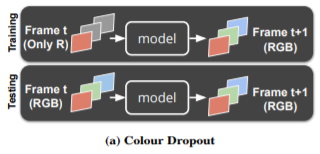

비디오로부터 N개의 프레임이 주어지면 CNN에 전달하여 feature embedding을 생성했습니다. 또한 이전 논문에서는 흑백 이미지만을 입력 프레임으로 전달했습니다. 이때문에 RGB 채널 correlation을 포착하지 못했는데 이 문제를 해결하는 방법입니다.

입력 프레임I에 augmentation g를 적용합니다. 논문에서는 g를 information bottleneck이라고 표현합니다. g는 (1) Colour Dropout, (2) perturb the vrightness, (3) contrast, saturation of an image로 이루어져 있습니다.

g를 통하여 색상에 robust한 정보를 학습할 수 있습니다.

(3) Scheduled Sampling

target frame과 regerence frame을 선정해야 하므로 두 개의 frame을 sample해야 합니다. 가까운 frame을 선정하면 객체의 변화가 거의 없기 때문에 학습하는 의미가 없습니다. 먼 frame을 선정하면 객체 가려짐과 같은 변수에 의해 예측의 난이도가 급상승 합니다.

이처럼 두 frame 사이의 거리에 따라 쉽고 어려운 samples을 선정할 수 있는데 두 gap을 감소시키기 위해 scheduled sampling을 사용합니다.

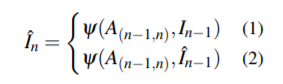

NLP의 teacher learning과 같이 reference frame을 모델의 예측값 혹은 ground truth 중 확률적으로 선택하게 합니다. 초기 학습 안정을 위해 gt를 선택할 확률을 0.9로 선정하고 0.6까지 서서히 낮춥니다.

n은 frame sequence에 존재하는 frame을 의미하는데 논문에서는 3을 사용합니다.

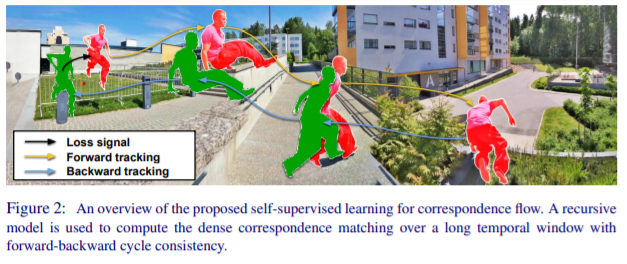

(4) Cycle Consistency

cycle consistence를 regularizer를 위해 사용합니다. cycle consistency가 cycle gan에서 제안된거 같은데.. 잘 모르겠네요. 논문에서도 자세히 설명하진 않습니다.

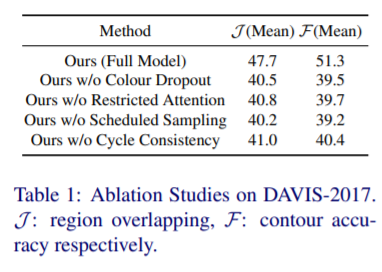

위에서 언급한 4가지 방법 중 하나라도 제거하면 성능에 큰 악영향을 줍니다.

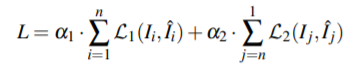

Loss function은 각 픽셀에 대한 colour를 k-means clustering을 수행하여 16개의 clustering으로 묶습니다. 16개의 범주에 대하여 cross entropy를 사용합니다.

앞 항은 forward patch, 두 번째 항은 backward path를 나타냅니다.

Experiment

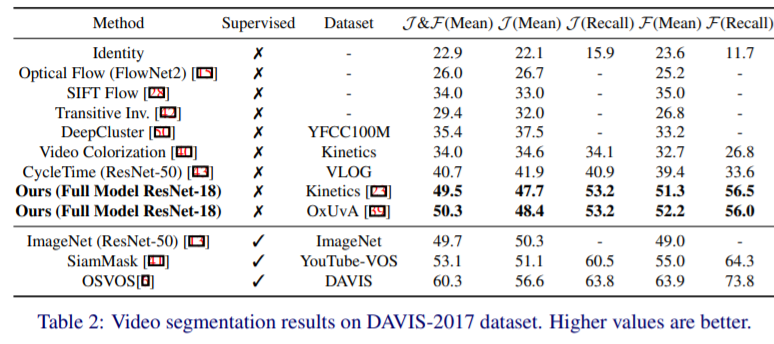

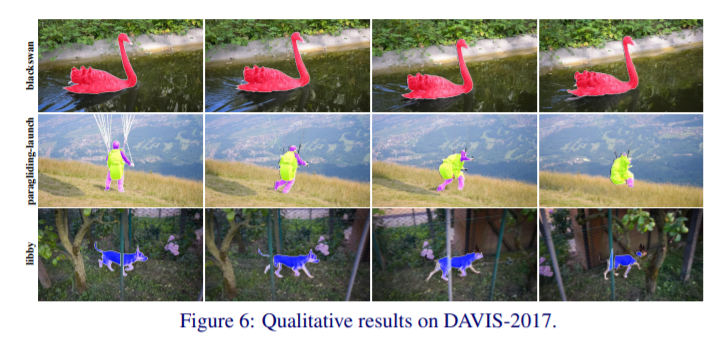

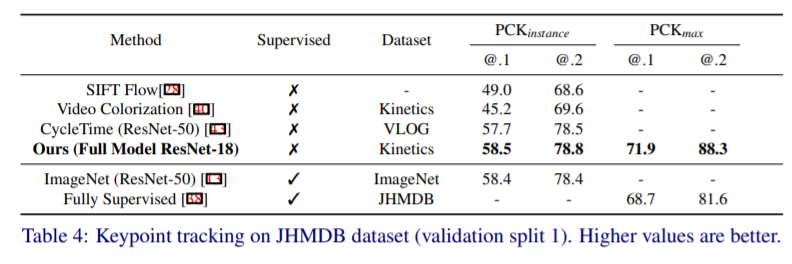

이렇게 학습한 모델은 Video Segmentation task와 Keypoint tracking에서 SOTA 성능을 달성합니다.

my github

Seonghoon-Yu/Paper_Review_and_Implementation_in_PyTorch

공부 목적으로 논문을 리뷰하고 해당 논문 파이토치 재구현을 합니다. Contribute to Seonghoon-Yu/Paper_Review_and_Implementation_in_PyTorch development by creating an account on GitHub.

github.com