Tracking Emerges by Colorizing Videos

PDF, Video SSL, Carl Vondrick, Abhinav Shrivastava, Alireza Fathi, Sergio Guadarrama, Kevin Murphy, ECCV 2018

Summary

Unlabeled Video 데이터의 색상을 활용하여 colorization 모델을 학습합니다. 흑백 frame에서 직접 색상을 예측하는 대신에 reference frame와 target frame 사이의 유사도를 계산한 후, reference frame의 색상을 copy하여 유사도를 사용해 target frame의 색상을 예측합니다.

비디오에서 색상은 일반적으로 temporally stable 합니다. 갑자기 불이 켜지거나 꺼지는 상황을 제외하고 객체는 일정한 색상을 갖고 있습니다. 이 색상 정보를 활용하여 모델을 학습시킬 수 있다면 사람이 직접 labeling 하는 번거로움을 제거할 수 있습니다.

색상공간은 Lab를 사용하며 reference frame과 target frame의 흑백 이미지를 CNN으로 각각 전달합니다. CNN이 출력한 두 개의 D차원 embedding 사이의 모든 픽셀에 대한 유사도를 계산합니다.

이 유사도 행렬을 사용하여 prediction을 계산합니다. 모든 픽셀에 유사도를 계산하는 것은 high computation 작업이지만 low spatial frequency인 color를 사용하므로 low resolution video를 활용합니다.

$c_i$는 reference frame의 true color입니다. $c_i$의 선형결합으로 target frame의 color 예측값 $y_j$를 계산합니다.

예측한 $y_i$와 target frame의 true color $c_j$ 사이의 cross entropy loss를 최소화하여 모델을 학습합니다.

$c_j$와 $y_j$가 픽셀값이면 cross entropy loss를 계산할 수 없습니다. 따라서 색상을 k-means(k=16)을 사용하여 quantizing 한 후 loss를 계산합니다. k개의 cluster를 categorical data로 사용하는 것입니다.

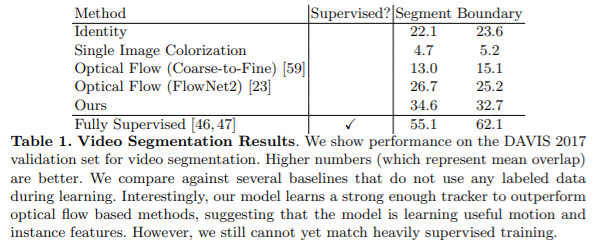

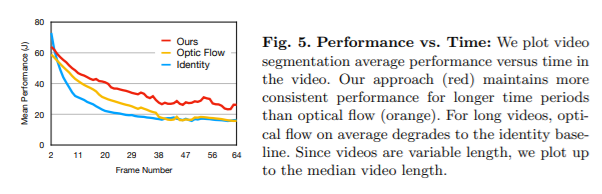

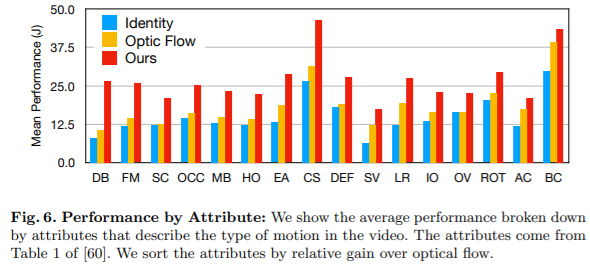

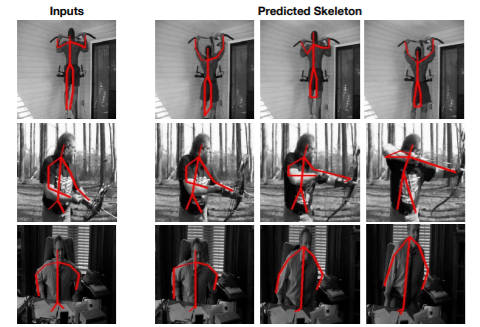

이렇게 학습한 모델은 (1) optical flow 모델보다 long video에 강인하며 (2) video segment task, tracking task 등 여러 task에 뛰어난 성능을 갖습니다.

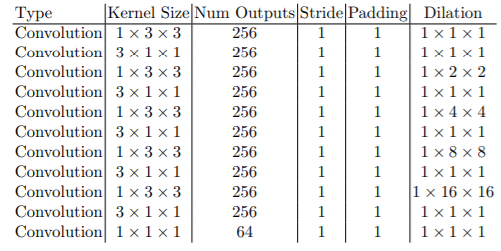

모델 구조입니다. 3D Conv를 사용하는 ResNet-18 모델을 사용합니다. 이 모델은 64 차원을 가진 embedding을 출력합니다.

Experiment

my github

Seonghoon-Yu/Paper_Review_and_Implementation_in_PyTorch

공부 목적으로 논문을 리뷰하고 해당 논문 파이토치 재구현을 합니다. Contribute to Seonghoon-Yu/Paper_Review_and_Implementation_in_PyTorch development by creating an account on GitHub.

github.com