부분집합 선택(Subset Selection)

부분집합 선택은 반응변수(response, Y)와 관련 없는 설명변수(predictor, X)를 식별하여 제거합니다. 반응변수와 관련 있는 설명변수의 집합에서 선형회귀를 진행하여 모델의 해석력을 높여줍니다.

이번 포스팅에서 (1) 최상의 부분집합 선택, (2) 전진 단계적 선택, (3) 후진 단계적 선택, (4) 하이브리드 방식을 살펴보겠습니다.

1. 최상의 부분집합 선택(Best Subset Selection)

작동원리

(1) 모든 가능한 predictor, p의 선형 결합에 대해 fitting을 진행합니다.

(2) 총 2^p번의 fitting이 진행됩니다.

(3) predictor을 1개 포함한 모델에서 RSS가 가장 낮은 모델이 M1로 선택합니다.

(4) predictor을 2개 포함한 모델에서 RSS가 가장 낮은 모델이 M2로 선택합니다.

(5) 이 과정을 p번 반복하여 Mp까지 선정합니다.

(6) M0~Mp 사이에서 Cross-validation error, Cp, AIC, VIC, adjusted R^2가 가장 낮은 모델을 선택합니다.

특징

- train에 대한 최고의 모델을 찾을 수 있지만, 2^p번 fitting을 수행해야 하므로 연산량이 많습니다.

- p가 아주 크면 사용할 수 없습니다.

- train dataset에 overfitting 될 수 있습니다.

2. 전진 단계적 선택(Forward Stepwise Selection)

특징

- (1+p(p+1))/2 번 fitting을 진행합니다.

- 최상의 부분집합 선택 방법보다 연산량에 이점이 있습니다.

- 최고의 모델을 보장하지 않습니다.

동작 원리

(1) 아무 설명변수를 갖고 있지 않은 M0, null model로 시작합니다.

(2) predictor을 1개 포함한 모델에 대하여 모든 predictor에 대해 선형 회귀를 진행합니다.

(3) RSS가 가장 낮은 모델을 M1로 지정합니다.

(4) M1에서 선택된 predictor을 포함하여, predictor을 하나 더 추가한 포함한 모델에 대해 선형 회귀를 수행합니다.

(5) RSS가 가장 낮은 모델을 M2로 지정합니다.

(6) 위 과정을 p번 반복하여 Mp까지 모델을 선택합니다.

(7) M0~Mp 모델에 대하여 CV error, Cp, AIC, BIC, adjusted R^2를 수행하고, 가장 적합한 모델을 선택합니다.

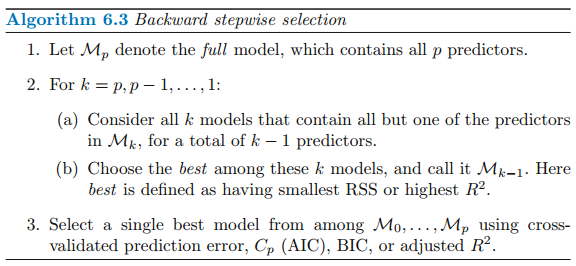

3. 후진 단계적 선택(Backward Stepwise Selection)

특징

- 전진 단계적 선택과 마찬가지로 최고의 모델을 보장하지 않습니다.

- 전진 단계적 선택과는 다르게 모든 설명 변수를 포함한 full least squear model에서 시작하여 반복적으로 하나씩 설명변수를 제거해 나갑니다.

- 후진 단계적 선택은 변수 수 p개보다 샘플 수 n개가 더 많아야 사용할 수 있습니다.

4. 하이브리드 방식(Hybrid Approaches)

특징

- 전진 단계적 선택과 후진 단계적 선택의 하이브리드 버전

- 변수들이 모델에 순차적으로 추가된 후, 모델 적합을 더 이상 향상시키지 않는 변수가 존재하는 경우에 제거한다.

- 전진 및 후진 단계적 선택의 계산적 장저은 유지하면서 최상의 부분집합 선택을 모방

참고자료 및 그림 출처

Gareth James의 An Introduction to Statistical Learning

'수학 > Statistical Learning' 카테고리의 다른 글

| [ISLR] 수축법(Shrinkage Methods), 능형 회귀(Ridge regression) (1) | 2021.05.31 |

|---|---|

| [ISLR] Cp, AIC, BIC, Adjusted R2, 검증 및 교차검증(Validation and Cross-Validation) (0) | 2021.05.30 |

| [ISLR] 교차검증(Cross-validation), K-Fold, LOOCV (0) | 2021.05.09 |

| [ISLR] Classification - Logistic Regression, LDA, QDA, KNN (0) | 2021.05.08 |

| [ISLR] 선형 회귀(Linear Regression) Python코드 (1) | 2021.05.03 |