ViViT: A Video VIsion Transformer

PDF, Video, Anurang Arnab, Mostafa Dehghani, Georg Heigold, Chen Sun, Mario Lucic, Cordelia Schmid, arXiv 2021

Summary

Video 데이터를 Vision Transformer에 적용하여 Video classification task를 수행합니다.

Tubelet embedding

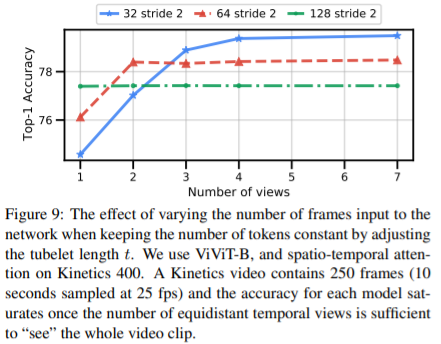

Tubelet embedding 방법을 사용하여 비디오를 embedding해 transformer로 전달합니다. 논문에서는 (h,w,t)16x16x2를 사용합니다.

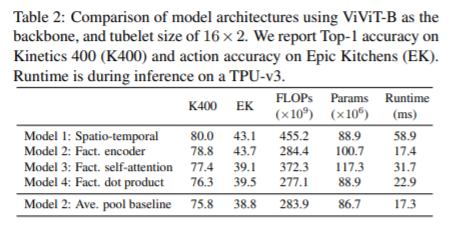

Video를 ViT에 적용하는 4가지 모델 variant를 제안합니다. 성능이 좋은 모델1과 모델2만 살펴보겠습니다.

Model 1: Spatio-temporal attention

단순히 모든 spatio-temporal token을 트랜스포머 인코더로 전달합니다. large-dataset에서 성능이 제일 좋지만 small dataset에서 overfitting이 발생하고 연산량이 매우 높습니다.

Model 2: Factorised encoder

각각의 frame에 대하여 Transformer를 적용한 후 출력값을 concat하여 다시 transformer에 전달합니다. 처음 transformer는 spatial 정보를 학습하고 나중 transformer는 temporal 정보를 학습합니다.

모델 1보다 연산량이 효율적입니다. large dataset에 대하여 model1보다 성능이 낮지만, small dataset에서는 성능이 더 높습니다.

Embedding weights

tubelet embedding을 사용할 때, embedding filter는 3D tensor입니다. 아래와 같이 초기화 합니다.

positional embedding은 2D image로 pretrained model의 positional embedding을 temporal axis로 repeat합니다.

Experiment

my github

Seonghoon-Yu/Paper_Review_and_Implementation_in_PyTorch

공부 목적으로 논문을 리뷰하고 해당 논문 파이토치 재구현을 합니다. Contribute to Seonghoon-Yu/Paper_Review_and_Implementation_in_PyTorch development by creating an account on GitHub.

github.com