Video Swin Transformer

PDF, TF Video, Ze Liu, Jia Ning, Yue Cao, Yixuan Wei, Zheng Zhang, Stephen Lin, Han Hu, arXiv 2021

Summary

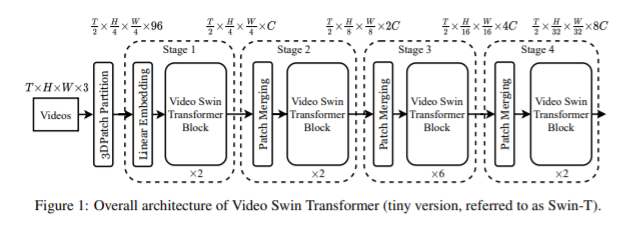

Swin transformer를 video로 확장시킨 논문.

video는 temporal dimension을 추가적으로 지니고 있어서 어떻게 확장하는지 유심히 볼 필요가 있습니다.

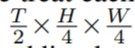

ViViT와는 다르게 joint self attention을 사용합니다. 3D patch embedding을 적용하여

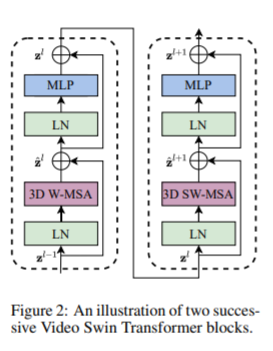

차원의 3D token을 얻고, 3D window size를 정의하여 3D window 개수를 계산합니다.

swin trasnformer와 동일하게 shifted window와 relative positional bias을 사용합니다. shifted window를 사용하면 window 수를 감소시킬 수 있어서 연산량에 이점이 됩니다.

swin transformer를 base로 사용하므로 pretrained 모델을 사용하는데 3D embedding과 relative position bias 두 가지에서 차이점이 있어 이를 어떻게 해결하느냐에 대한 내용도 논문에 나와있습니다.

Experiment

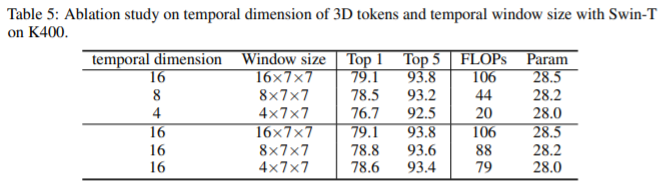

흥미로운 점은 ablation study에 있습니다. temporal window size가 accuracy-speed trade off를 조절합니다.

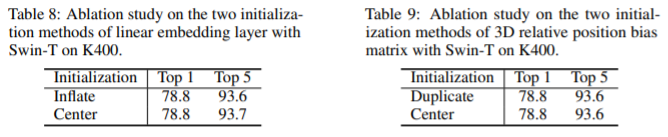

ViViT에서 효과적인 Center initialization은 inflate initialization과 성능이 동일합니다.

my github

Seonghoon-Yu/Paper_Review_and_Implementation_in_PyTorch

공부 목적으로 논문을 리뷰하고 해당 논문 파이토치 재구현을 합니다. Contribute to Seonghoon-Yu/Paper_Review_and_Implementation_in_PyTorch development by creating an account on GitHub.

github.com