Is Space-Time Attention All You Need for Video Understanding?

PDF, Video TF, Gedas Bertasius, Heng Wang, Lorenzo Torresani, ICML 2021

Summary

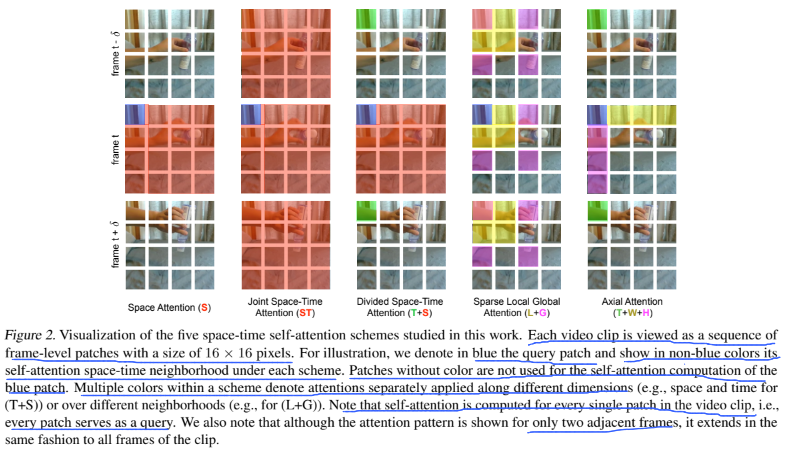

Transformer를 Video domain에 적용한 논문입니다. video는 sentence와 같이 sequential한 데이터로 볼 수 있습니다. word가 연속되는 것처럼 frame이 연속되기 때문입니다.

Convolution을 self-attention으로 대체한다면 convolution이 갖고 있는 inductive bias 문제를 완화할 수 있습니다. conv는 적은 데이터 셋에 효과적이지만 데이터 수가 풍부할 경우 local한 영역에 제한되어 특징을 추출하는 conv는 단점이 될 수 있습니다.

conv kernel은 sort-range information을 포착하므로 receptive field를 넘는 dependency를 modeling할 수 없습니다. conv는 단지 shorter-range information을 통합하여 long-range 정보를 학습합니다.

transformer는 CNN 보다 training과 inference 속도가 빠르다는 몇몇 실험 결과가 존재합니다.

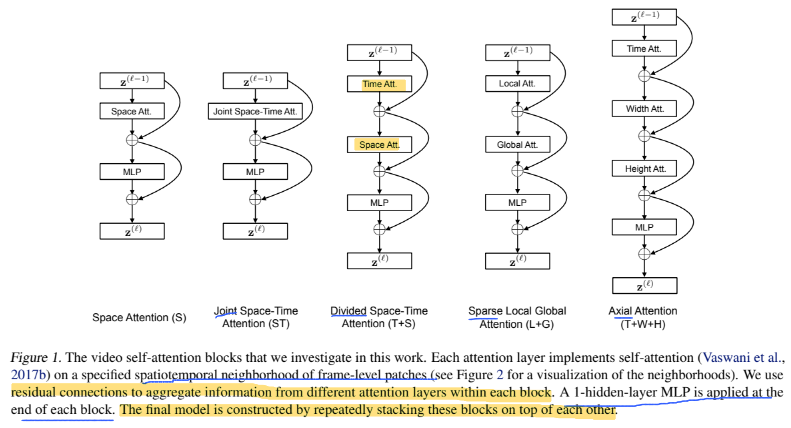

transformer의 단점은 similarity를 계삲하는 연산량이 비싸다는 것인데 해다 논문에서는 divided attetnion을 제안하여 이를 완화합니다.

Divided Space-Time Attention이 가장 성능이 뛰어납니다.

patch를 어떻게 쪼개서 flatten 하는지 봐야할 필요가 있는데 코드 봐야겠다.

Experiment

이미지를 3 spatial crop해서 최종 출력은 3 crops를 평균.

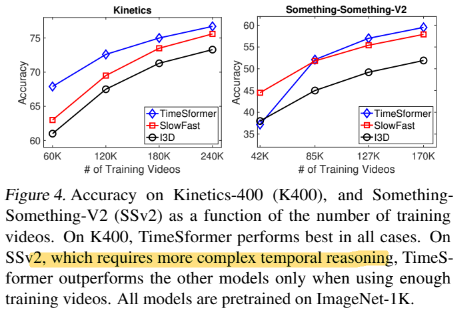

spatial cues가 temporal information보다 더 중요.

transformer가 CNN 모델보다 inference, train이 더 빠름.

TF가 params가 월등하게 많은데 이는 large-scale learning에 더 적합한 setting을 암시

GPU hours가 416시간인데.... video는 GPU 사용량이 진짜 엄청나네요

모델의 파라미터가 크다보니 pretrain 모델을 불러와서 학습을 하는데 어떻게 image로 학습한 모델을 video로 적용하는지도 봐야할것 같다

논문을 보면 TimeSformer와 CNN base model 비교하는 실험을 많이 했다.

kinetics는 spatially biased 되어있고 SSv2는 complex temporal.

my github

Seonghoon-Yu/Paper_Review_and_Implementation_in_PyTorch

공부 목적으로 논문을 리뷰하고 해당 논문 파이토치 재구현을 합니다. Contribute to Seonghoon-Yu/Paper_Review_and_Implementation_in_PyTorch development by creating an account on GitHub.

github.com

'논문 읽기 > Video Recognition' 카테고리의 다른 글

| [논문 읽기] VTN(2021), Video Transformer Network (0) | 2021.09.12 |

|---|---|

| [논문 읽기] MViT(2021), Multiscale Vision Transformers (0) | 2021.09.12 |

| [논문 읽기] Video Swin Transformer(2021) (0) | 2021.09.06 |

| [논문 읽기] ViViT: A Video Vision Transformer(2021) (0) | 2021.08.25 |

| [논문 읽기] VisTR(2020), End-to-End Video Instance Segmentation with Transformers (0) | 2021.08.20 |