Multiscale Vision Transformers

PDF, Video TF, Haoqi Fan, Bo Xiong, Karttikeya Mangalam, arXiv 2021

Summary

ViT를 Video에 적용한 논문입니다.

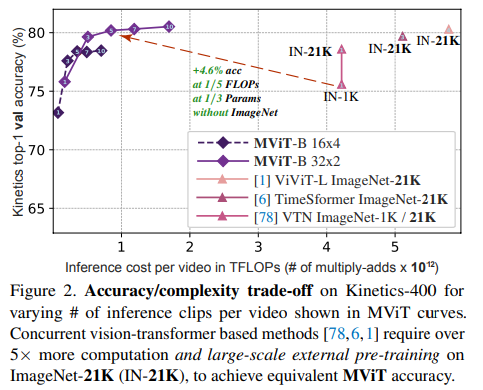

이전의 ViT + Video 논문과는 다르게 pre-trained 없이 뛰어난 성능을 보여줍니다.

해당 논문의 특징은 계층 구조를 활용한 모델입니다. 어떻게 계층 구조를 구현했는지 살펴보겠습니다.

stage 구조를 지니는데 각 stage는 다수의 transformer block으로 이루어져 있습니다. 각 stage 앞단마다 resolution을 pooling하여 down sample하고 채널 수를 확장합니다. CNN 모델에서 사용하는 계층 구조 원리를 따릅니다.

Qeury, Key, Value로 변환하는 Linear이후에 Pooling 연산을 추가합니다. 또 residual connection 시에 축소된 해상도와 입력값을 맞춰주기 위해서 여기에도 pooling을 추가합니다. 아래 표를 살펴보면 3x3x3 conv pooling 연산이 가장 뛰어납니다.

my github

Seonghoon-Yu/Paper_Review_and_Implementation_in_PyTorch

공부 목적으로 논문을 리뷰하고 해당 논문 파이토치 재구현을 합니다. Contribute to Seonghoon-Yu/Paper_Review_and_Implementation_in_PyTorch development by creating an account on GitHub.

github.com

'논문 읽기 > Video Recognition' 카테고리의 다른 글

| [논문 읽기] X3D(2020), Expanding Architectures for Efficient Video Recognition (0) | 2021.09.20 |

|---|---|

| [논문 읽기] VTN(2021), Video Transformer Network (0) | 2021.09.12 |

| [논문 읽기] TimeSformer(2021), Is Space-Time Attention All You Need for Video Understanding? (0) | 2021.09.10 |

| [논문 읽기] Video Swin Transformer(2021) (0) | 2021.09.06 |

| [논문 읽기] ViViT: A Video Vision Transformer(2021) (0) | 2021.08.25 |