반응형

Space-time Mixing Attention for Video Transformer

PDF, Video, Adrian Bulat, Juan-Manuel Perez-Rua, Swathikiran Sudharan, Brais Martinez, Georgios Tzimiropolos, arXiv 2021

Summary

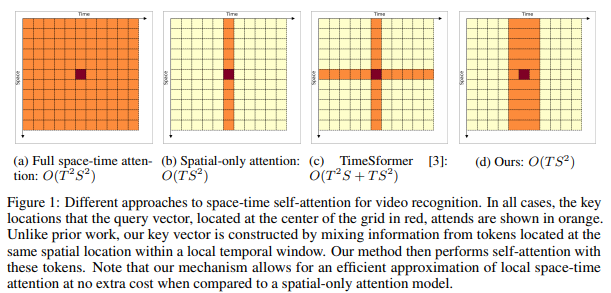

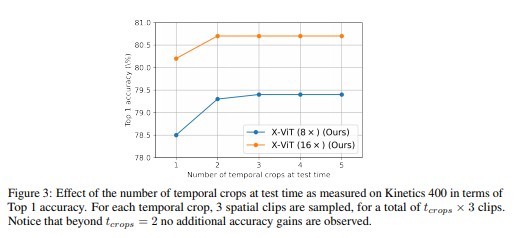

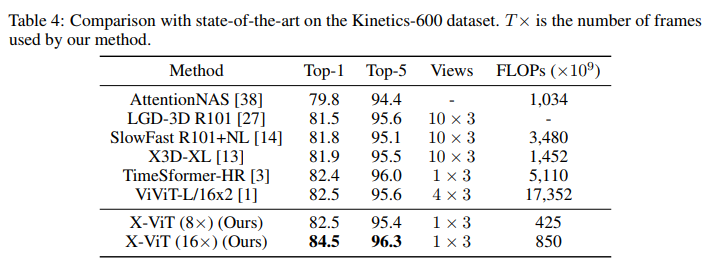

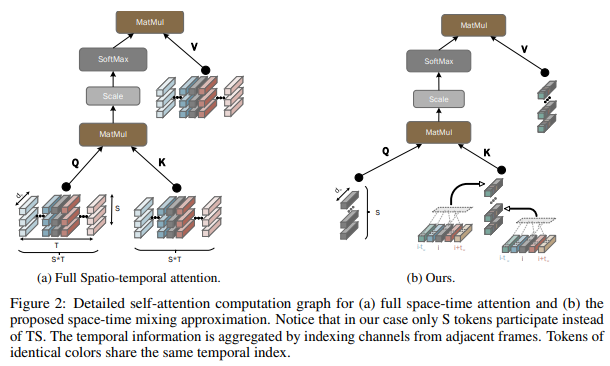

ViT를 Video에 적용한 논문입니다. self-attention의 계산 복잡도를 O(TS^2)로 감소시키는데 어떤 방법을 이용하는지 살펴볼 필요가 있는 것 같습니다. 성능도 잘 나오고 FLOPs 관점에서 엄청난 이점을 갖습니다.

Method를 살펴보면 이해가 잘 안갑니다. 코드를 뜯어봐야 이해가 될 것 같네요.

my github

Seonghoon-Yu/Paper_Review_and_Implementation_in_PyTorch

공부 목적으로 논문을 리뷰하고 해당 논문 파이토치 재구현을 합니다. Contribute to Seonghoon-Yu/Paper_Review_and_Implementation_in_PyTorch development by creating an account on GitHub.

github.com

반응형