VideoLightFormer: Lightweight Action Recognition using Transformers

PDF, Video Recognition, Raivo Koot, Haiping Lu, arXiv 2021

Summary

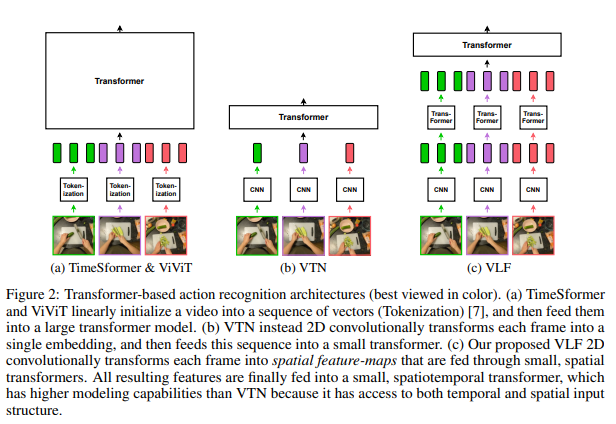

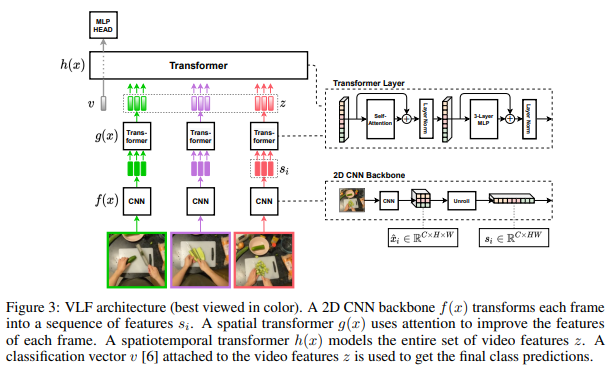

efficient한 Video Recognition 모델입니다. VTN의 확장 버전이며 CNN 백본으로 각 frame을 저차원의 ebedding으로 압축한 뒤에 각 embedding에 spatial transformer를 적용하고, spatial-time transformer를 적용합니다. 해당 모델의 가장 큰 장점은 latent가 낮다는 것입니다. 저자의 목표가 efficient 모델을 추구하여 각 요소를 최대한 high-efficiency되도록 설계합니다.

실험 데이터셋은 temporally-demanding dataset인 EPIC-KITCHENS-100과 Something-Something V2를 사용합니다.

모델은 간단 합니다. (1) CNN backbone (2) spatial transformer (3) spatiotemporal transformer (4) MLP head로 이루어져 있습니다. CNN Backbone에서 저차원의 embedding을 추출하는데, 이 embedding이 low-resolution이기 때문에 transformer의 연산량을 감소할 수 있습니다.

Experiment

my github

Seonghoon-Yu/Paper_Review_and_Implementation_in_PyTorch

공부 목적으로 논문을 리뷰하고 해당 논문 파이토치 재구현을 합니다. Contribute to Seonghoon-Yu/Paper_Review_and_Implementation_in_PyTorch development by creating an account on GitHub.

github.com