Towards Training Stronger Video Vision Transformers for EPIC-KITCHENS-100 Action Recognition

PDF, VIdeo Recognition, Ziyuan Huang, Zhiwu Qing, Xiang Wang, Yutong Feng, Shiwei Zhang, arXiv 2021

Summary

해당 논문은 21.06에 arxiv에 올라온 논문입니다. Video Recognition 모델을 EPIC-KITCHENS-100 데이터셋에 여러가지 학습 방법을 실험합니다. 모델을 학습시킬시에 여러 가지를 고려해야 하는데 이 논문이 참고 사항이 될 수 있을 것 같네요 ㅎㅎ

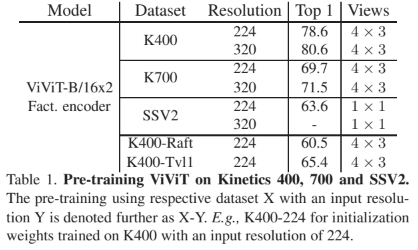

우선 ViViT를 kinetics400, 700, SSV2로 pre-train 한뒤에 EK dataset에 fine tuning 합니다.

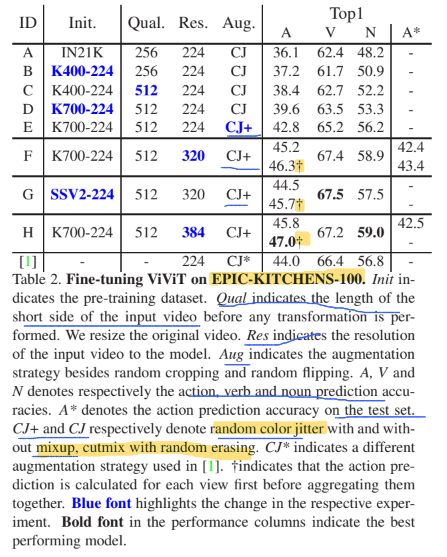

Qual은 transformation을 적용하기 전 비디오의 short side를 의미하고, Res는 transformation 적용 후 video resolution 크기, Aug는 strong augmentation 적용 여부를 나타냅니다. init은 pretrained dataset 입니다. resolution은 크면 좋고, Strong aug를 적용하면 성능이 향상된다는 것을 보여줍니다.

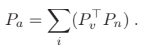

최종 action prediction을 계산하는 방법은 두 가지가 있는데 아래 방법을 사용하면 성능이 더 향상됩니다. 서로 다른 view를 aggregating하기 전에 action prediction을 계산하는 것입니다.

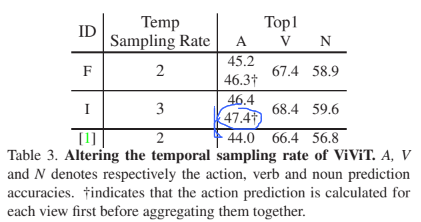

Temporal sampling stride도 성능에 중요한 요소입니다.

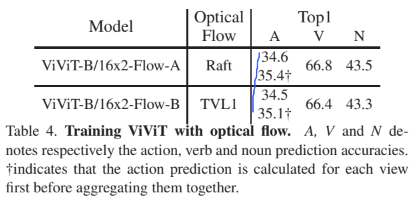

optical flow를 사용한 실험도 합니다.

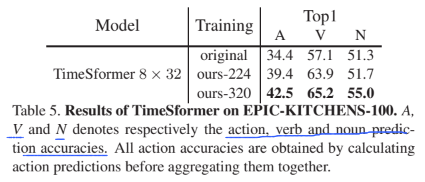

ViViT 모델이 아닌 TImeSformer 모델에 training recipe를 적용한 실험입니다.

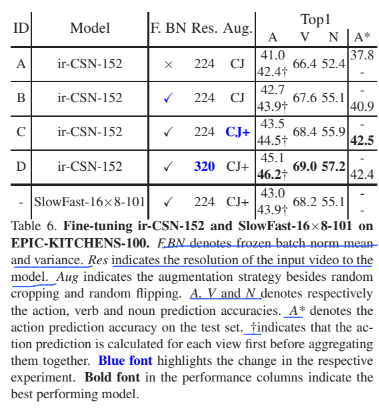

CNN base 모델도 실험을 합니다.

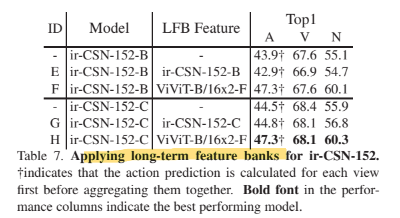

long-term feature bank를 사용한 실험입니다.

여러 모델을 앙상블한 결과.

my github

Seonghoon-Yu/Paper_Review_and_Implementation_in_PyTorch

공부 목적으로 논문을 리뷰하고 해당 논문 파이토치 재구현을 합니다. Contribute to Seonghoon-Yu/Paper_Review_and_Implementation_in_PyTorch development by creating an account on GitHub.

github.com