CaSP, Class agnostic Semi-Supervised Pretraining for Detection and Segmentation

https://arxiv.org/abs/2112.04966

CaSP: Class-agnostic Semi-Supervised Pretraining for Detection and Segmentation

To improve instance-level detection/segmentation performance, existing self-supervised and semi-supervised methods extract either very task-unrelated or very task-specific training signals from unlabeled data. We argue that these two approaches, at the two

arxiv.org

semi seg or detection 논문.

기존의 semi 는 labeled data와 unlabeled data를 joint하여 학습시킨다.

이 논문은 class agnoistic unlabeled data로 pre-training 한뒤에 labeled data로 fine-tuning을 한다.

위 논문은 3가지 process가 존재한다.

(1) Early pretraining

detection dataset에서 class 정보를 제거하고 class-agnoistic한 data로 detector를 학습시킨다. localization만 집중하기 때문에 localization 성능이 class-specific data로 학습 시킨 것 보다 agnoistic 한게 더 높게 나온다.

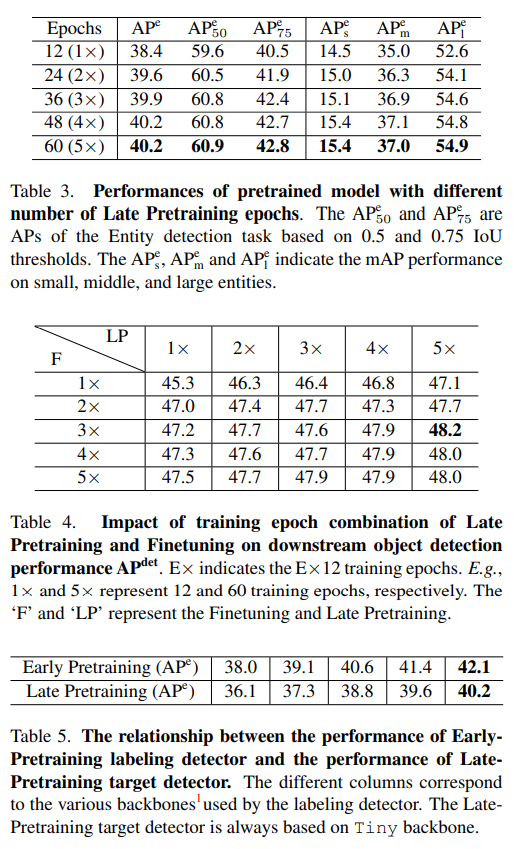

(2) Late pretraining

(1)로 학습한 모델로 unlabeled data로부터 pseudo label을 생성해 target detector를 학습시킨다. 역시 class agnoistic하게.

(3) fine-tuning

이제 target detector를 down-stream dataset에 class 정보와 함께 학습시킨다.

GitHub - Seonghoon-Yu/AI_Paper_Review: 까먹으면 다시 보려고 정리합니다.

까먹으면 다시 보려고 정리합니다. Contribute to Seonghoon-Yu/AI_Paper_Review development by creating an account on GitHub.

github.com