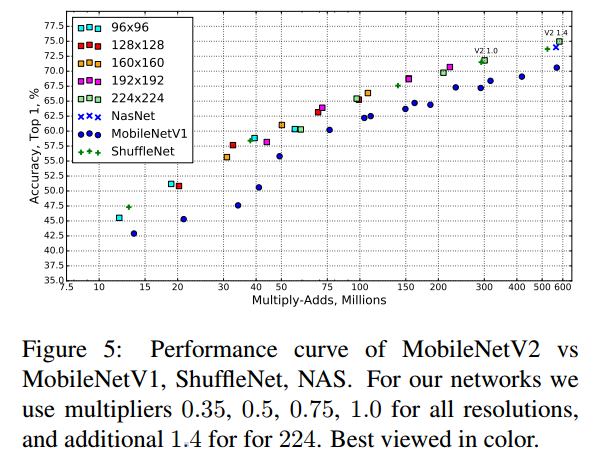

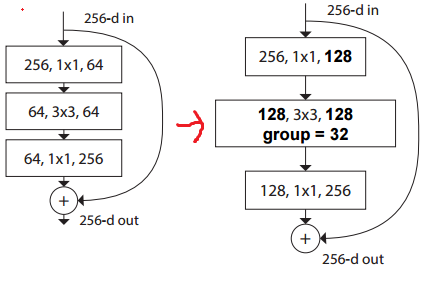

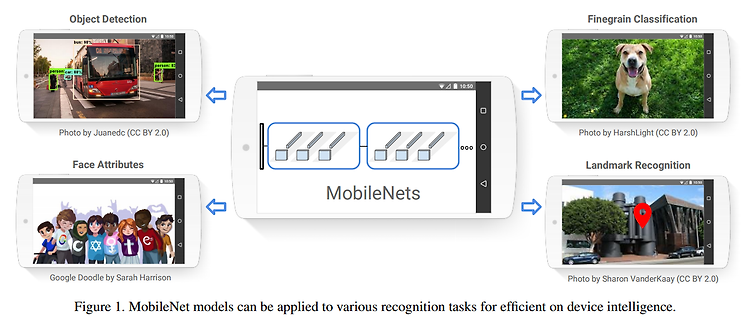

안녕하세요! 이번에 읽어볼 논문은 MobileNetV2: Inverted Residuals and Linear Bottlenecks 입니다. MobileNetV2는 MobileNetV1의 후속작 입니다. MobileNetV1에 대해 궁금하신 분은 아래 포스팅을 참고해주세요. [논문 읽기] MobileNet(2017) 리뷰, Efficient Convolutional Neural Networks for Mobile Vision Applications 이번에 읽어볼 논문은 MobileNets: Efficient Convolutional Neural Networks for Mobile Vision Application 입니다. MobileNet은 Depthwise separable convolution을 활용..