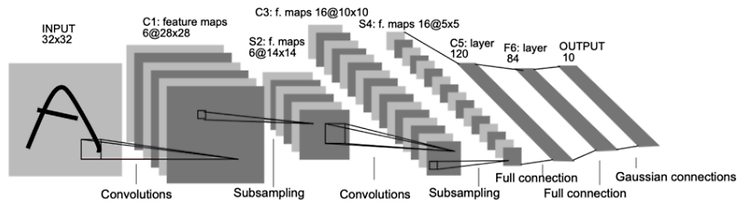

이번에 소개할 논문은 2017년에 나온 Inception-v4, Inception-ResNet and the Impact of Residual Connections on Learning 입니다. 저자는 Szegedy 입니다. Inception-v1(GoogLeNet), Inception-v2, v3은 이미지 분류 대회에서 항상 좋은 성적을 거둬왔습니다. Inception 계열의 특징은 적은 파라미터수를 갖지만 모델이 다소 복잡합니다. 이 복잡성 때문에 VGGnet이 GoogLeNet보다 흔하게 사용되었죠. inceptio-v1에서 개선된 v4에는 어떤 점이 변화되었는지 살펴보겠습니다. 이 논문에서 Inception-v4와 Inception-ResNet을 소개합니다. Inception-v4는 Incepti..