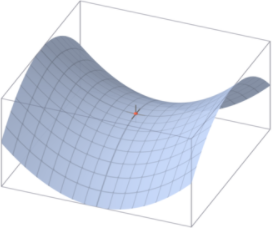

사이토고키의 을 공부하고 정리하였습니다. 매개변수 갱신 - Adam 모멘텀은 공이 그릇 바닥을 구르는 듯한 움직임을 보였습니다. AdamGrad는 매개벼수의 원소마다 적응적으로 갱신 정도를 조정했습니다. 두 기법을 융합한 기법이 바로 Adam입니다. 위 두 방법의 이점을 조합했으므로 매개변수 공간을 효율적으로 탐색해줄 것이라고 기대할 수 있습니다. 하이퍼파라미터의 '편향 보정'이 진행된다는 점도 Adam의 특징입니다. Adam에 의한 최적화 갱신 경로를 확인해보겠습니다. Adam 갱신 과정도 모멘텀과 비슷한 패턴으로 움직입니다. 이는 학습의 갱신 강도를 적응적으로 조정해서 얻는 혜택입니다. Adam은 하이퍼파라미터를 3개 설정합니다. 하나는 지금까지의 학습률, 나머지 두 개는 일차 모멘텀용 계수와 이차 ..