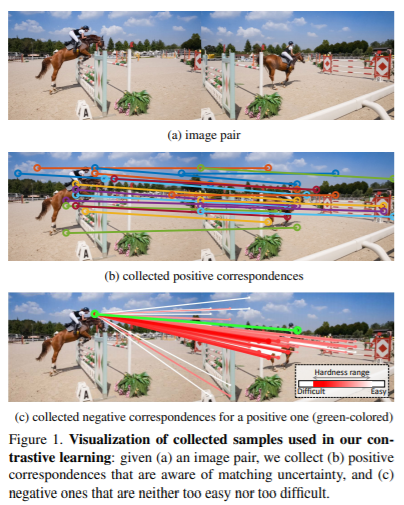

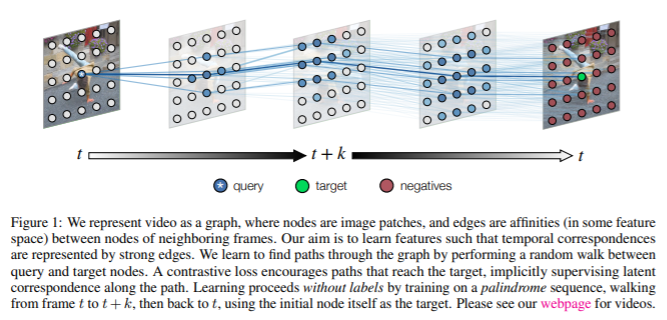

Mining Better Samples for Contrastive Learning of Temporal Correspondence PDF, Video SSL, Sangryul Jeon, Dongbo Min, Seungryong Kim, Kwanghoon Sohn, CVPR 2021 Summary Contrastive learning을 활용하여 correspondence matching을 수행하는 video SSL 논문입니다. 해당 논문은 matching uncertainty를 측정하기 위해 3가지 기준을 사용합니다. (1) pixel-level에서 Forward-backward consistency, (2) image-level에서 optimal transport, (3) video-level에서 te..